Stellt euch vor, in eurer Klasse wird ein Video herumgeschickt. Darin ist ein Mitschüler zu sehen, der etwas total Peinliches sagt. Er selbst bestreitet, der Junge in dem Video zu sein. Doch keiner glaubt ihm. Schließlich ist das sein Gesicht, seine Stimme. Sogar sein typisches leichtes Stottern ist zu hören. Keine Frage: Das muss er sein. Oder?

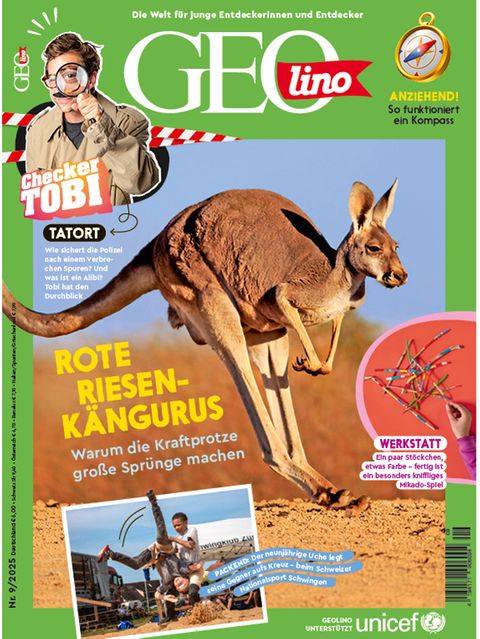

Dieser Artikel stammt aus unserer GEOlino-Ausgabe Nr. 09/2022:

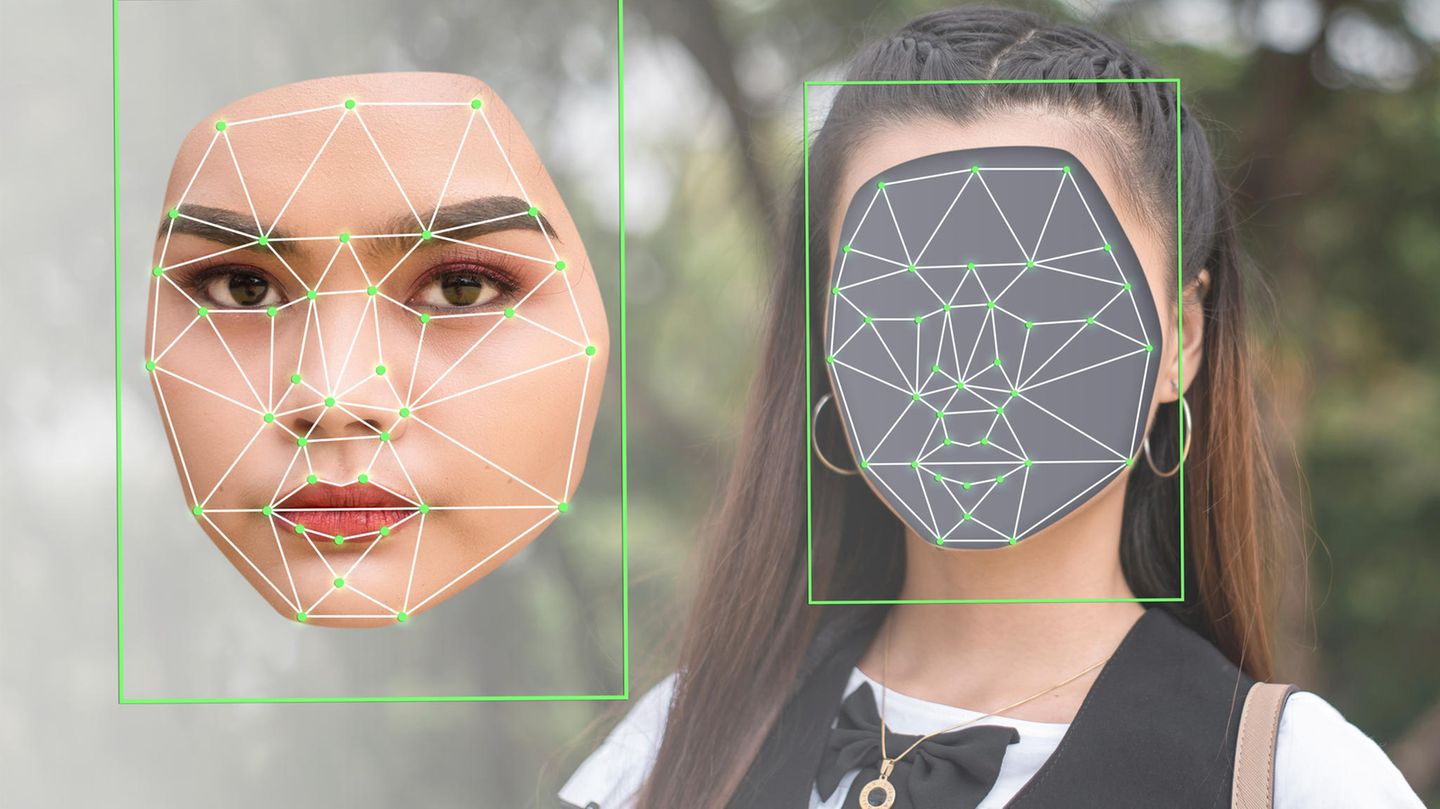

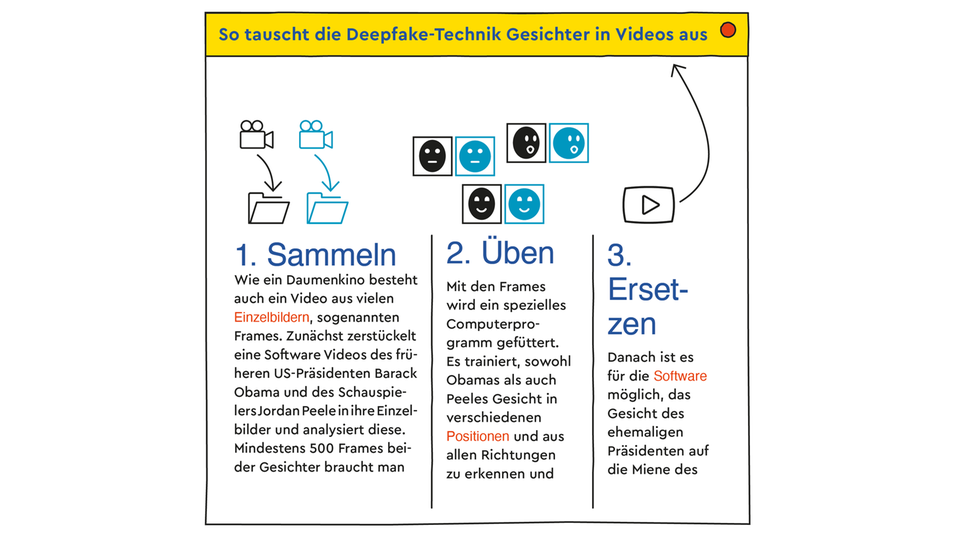

Muss er nicht. Es gibt nämlich eine Technik, mit der sich täuschend echte Fotos, Videos und Sprachbotschaften erstellen lassen. Sie wird „Deepfaking“ genannt. „Fake“ heißt auf Englisch „Fälschung“. Und „deep“ steht für „deep learning“, also für selbstlernende Software. Diese wird mit Videos oder Tonaufnahmen einer Person gefüttert. Mithilfe der Daten lernt der Computer, die Stimme und Gesichtsausdrücke der Person nachzuahmen. Man kann sie dann die verrücktesten Dinge sagen und tun lassen. Es ist wie ein Marionettenspiel – bei dem die Puppen wie Menschen wirken.

Echt verwirrend: Ein Internetnutzer erlaubte sich mit einem ursprünglich ernsten Interview mit einem General der Bundeswehr einen Scherz: Mithilfe der Deepfake-Technologie verwandelte er den General in den britischen Schauspieler Rowan Atkinson, besser bekannt als Mr. Bean:

Falls ihr ein Smartphone besitzt, habt ihr vielleicht schon einen Deepfake erstellt. Vermutlich sogar von euch selbst: Es gibt Apps, die euch altern lassen, mit Falten, grauen Haaren und Zauselbart in eurem Gesicht. Oder ihr zaubert euch in eine Filmszeneund werdet plötzlich zum Hobbit. Deepfakes können echt witzig sein …

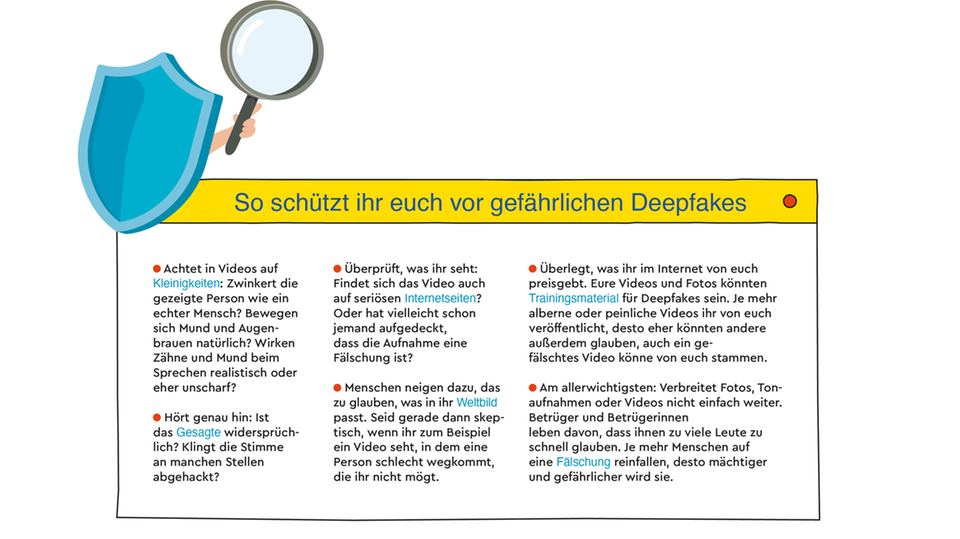

Oft sind sie auch leicht zu erkennen, denn noch ist die Technik nicht ausgereift. In vielen Videos erinnern die Personen an Roboter. Die Sprache klingt abgehackt. Die Mundwinkel hüpfen seltsam. Der Kopf wirkt wie auf den Hals geschraubt.

Doch die Software lernt dank künstlicher Intelligenz schnell hinzu. „In wenigen Jahren werden selbst Menschen, die geschult sind, Fälschungen aufzuspüren, diese kaum noch erkennen können“, sagt Patrick Aichroth.

Der 51-Jährige leitet am Fraunhofer-Institut für Digitale Medientechnologie in Ilmenau eine Fachgruppe. Die Expertinnen und Experten dort erforschen Deepfakes und versuchen sie aufzuspüren. Wer früher einen Deepfake erstellen wollte, musste technisch extrem fit sein und viel Datenmaterial besitzen, berichtet Aichroth. „Inzwischen lässt sich schon mit wenig Aufwand und aus ein paar Gesprächsfetzen aus Youtube-Videos ein gefälschter Anruf herstellen.“

Lassen sich Deepfakes spielerisch leicht in die Welt setzen, drohen große Gefahren! Davor warnt auch der ehemalige Präsident der USA, Barack Obama, in einem Video – könnte man meinen. In Wirklichkeit steckt der US-Schauspieler und Regisseur Jordan Peele dahinter. Mithilfe der Deepfake-Technik übertrug er die Gesichtszüge des früheren Präsidenten auf seine.

Und im Ukraine-Krieg tauchte ein Video auf, in dem der ukrainische Präsident Wolodymyr Selensky sein Land scheinbar dazu aufruft, sich zu ergeben. Mutmaßlich handelte es sich um eine Fälschung aus Russland. Schlimmstenfalls könnten Deepfakes also benutzt werden, um sich in Kriege einzumischen. Oder um Gruppen gegeneinander aufzuhetzen.

Experten wie Patrick Aichroth und auch die Polizei müssen ständig hinzulernen, um Deepfakes weiter aufdecken zu können. „Es ist Detektivarbeit“, sagt Aichroth. Zum Beispiel untersucht er verdächtige Aufnahmen auf ungewöhnliche, für den Menschen kaum hörbare Geräusche, die im echten Leben nicht vorkommen.

Die Technik hinter den Deepfakes kann aber auch nützlich sein. Menschen, die nach einer Krankheit oder einem Unfall verstummen, gibt sie ihre Stimme zurück. Wer blind ist oder nie lesen lernte, kann sich Bücher und Briefe vorlesen lassen – von einer vertrauten Stimme, nicht von einer, die klingt wie die U-Bahn-Ansage. Auch Wiederauferstehungen werden möglich: Durch ein Kunstmuseum in Florida scheint Salvador Dalí höchstselbst zu führen – obwohl der berühmte Maler vor über 30 Jahren starb.

Es ist wie mit den meisten Technologien: Erst in den falschen Händen werden sie zur Gefahr. Auch Patrick Aichroths Mutter erhielt schon einen Fake-Anruf. Eine Bekannte bat am Telefon um Geld. Die Stimme klang echt. Die Mutter aber wurde stutzig, als die angebliche Bekannte etwas Untypisches sagte. Auf eine kritische Frage der Mutter konnte die Computerstimme nicht reagieren – der Schwindel flog auf. Die künstliche Intelligenz der Software imitiert Gespräche eben nur. Wie ein Papagei, der auch nicht weiß, was er plappert. Plötzliche Gegenfragen und Themenwechsel bringen die Software aus dem Konzept.

Patrick Aichroths Rat lautet daher: „Immer kritisch bleiben.“ Man sollte nicht alles glauben, was man hört und sieht. Im Zweifelsfall sollten wir seltsame Videos nicht weiterverbreiten. Dass jemand Deepfakes erstellt, können wir nämlich kaum verhindern. Dass sie in Umlauf geraten, hingegen schon.