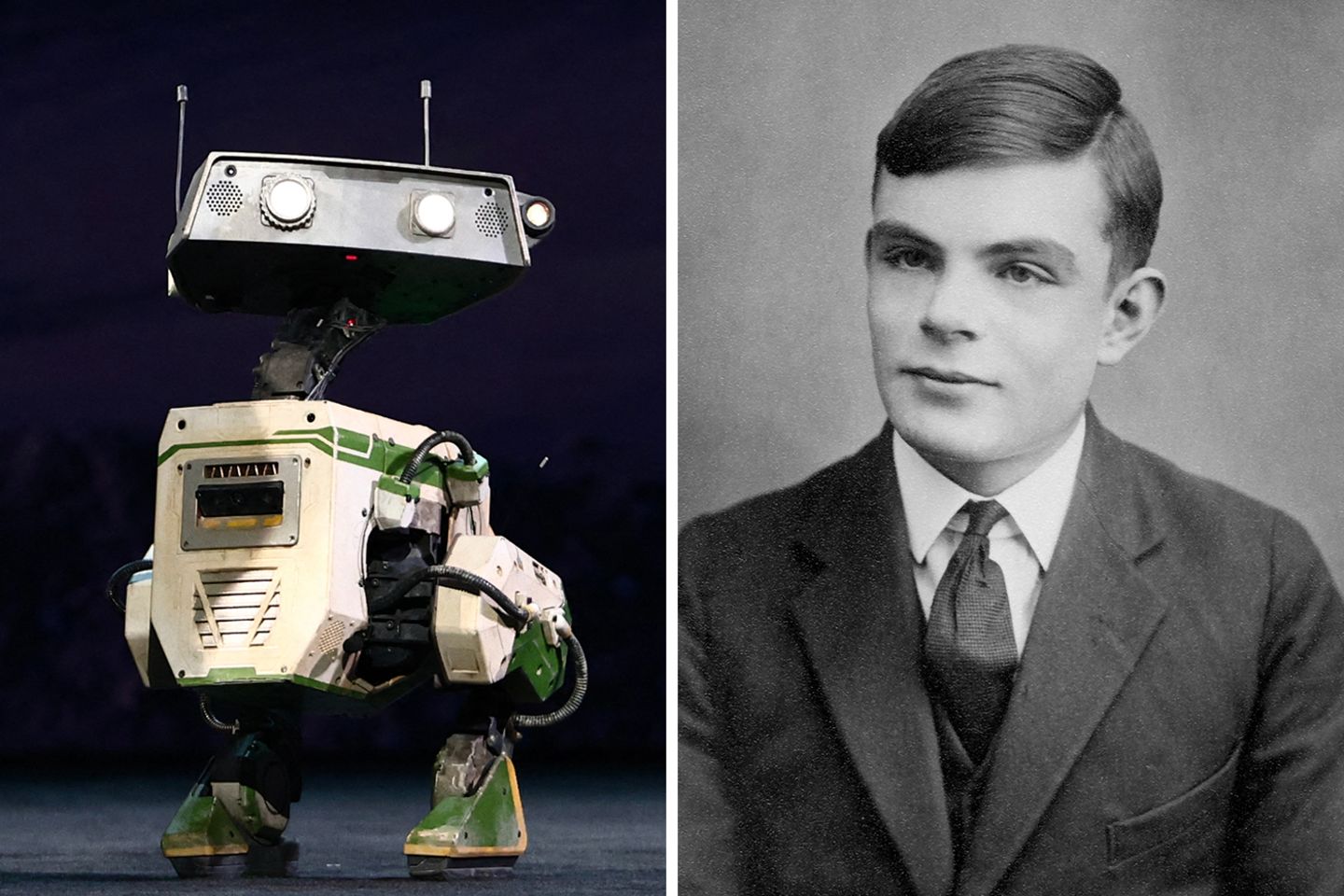

Als Alan Turing seinen weltberühmten Intelligenztest für Maschinen entwickelte, gab es noch keine Computer. Zumindest nicht im Wortsinn unserer Gegenwart. Künstliche Intelligenz, humanoide Roboter und große Sprachmodelle waren ferne Visionen. Dass Maschinen einmal das menschliche Denken überflügeln könnten: Science-Fiction-Dystopie.

Doch Turing, ein eigenbrötlerischer Mathematiker aus London, war seiner Zeit zwei Schritte voraus. In den 1930er-Jahren verfasste er theoretische Abhandlungen, die bald darauf wegweisend wurden für die Informatik. Während des Zweiten Weltkrieges entzifferte er die Codes, mit denen die Deutschen ihre Funksprüche verschlüsselten. Nach Kriegsende, Turing lehrte nun als Professor an der Universität Manchester, veröffentlichte er einen Essay, den jede Informatikstudentin kennt. Er beschreibt die Grundzüge des Turing-Tests. Noch heute muss ihn jede Form der Künstlichen Intelligenz durchlaufen, will sie öffentlichkeitswirksam ihre Klugheit unter Beweis stellen.

Der Turing-Test prüft das schauspielerische Können der Künstlichen Intelligenz

Dabei war Turings Essay weniger als konkreter Test gedacht und vielmehr ein Gedankenexperiment. Turing selbst sprach nie vom "Turing-Test", sondern von einem "Imitationsspiel". Darin kommuniziert eine Versuchsperson zunächst mit zwei ihr unbekannten Menschen: mit einem Mann und mit einer Frau. Die Versuchsperson sieht ihre Gesprächspartner nicht, kommuniziert schriftlich mit ihnen. Mit frei wählbaren Fragen soll sie binnen weniger Minuten herausfinden, wer Mann und wer Frau ist. Während die Frau der Versuchsperson mit ihren Antworten helfen darf, soll der Mann Verwirrung stiften.

Dann wird der Mann durch eine Maschine ersetzt. Nun soll sie Verwirrung stiften, die Versuchsperson auf die falsche Fährte locken. Fliegt die Maschine dabei nicht wesentlich häufiger auf als der Mann im ersten Szenario, hat sie den Test bestanden. Sie kann, laut Turing, "denken".

Zum einen muss sie dafür Grundlegendes beherrschen: Sie muss sich sicher in menschlichen Sprachsystemen bewegen, muss einigermaßen fehlerfrei auf Fragen antworten, mit denen sie zuvor möglicherweise noch nie konfrontiert wurde. Um die Versuchsperson allerdings auf die falsche Fährte zu locken, braucht es mehr. Die Maschine muss die Welt kennen. Sie muss wissen, welche sozialen Rollen mit der binären Geschlechtertrennung verbunden sind, welche Antworten ein stereotypischer Mann geben würde und welche eine stereotypische Frau.

Zudem muss die Maschine ihrer eigenen Rolle im Spiel gewahr sein, muss bewusst täuschen. Die Maschine muss sich in ihr menschliches Gegenüber hineinversetzen und ihm dreist ins Gesicht lügen. Verfüge eine Maschine über all diese Fähigkeiten, argumentierte Turing, wäre ihr Rechenvorgang nicht weit entfernt von einem menschlichen Bewusstsein, von menschlichen Denkprozessen. Sie wäre in unserem Sinne "intelligent".

Das chinesische Zimmer: John Searles Gegenargument

In den 1950er-Jahren nahm die Forschung zu Künstlicher Intelligenz Fahrt auf. Forscherinnen und Forscher diskutierten zum ersten Mal auf Konferenzen über die Möglichkeit, neuronale Netze selbst zu erschaffen. Sie diskutierten, wie eine Maschine die echte Welt wahrnehmen könnte, wie sie diese Eindrücke in abstrakte Begriffe verarbeiten könnte. Wie sie vielleicht sogar kreativ denken könnte. Turings Gedankenexperiment wurde schnell zum Gradmesser für diese neue, damals noch in weiter Ferne liegende Form der Intelligenz. Allerdings in deutlich vereinfachter Form.

In diesem bis heute gängigen Turing-Test kommuniziert erneut ein Mensch mit zwei Unbekannten. Der eine Gesprächspartner ist ein Mensch, der andere eine Maschine. Wieder erfolgt die Kommunikation schriftlich, wieder versucht die Maschine einen Menschen zu mimen. Gelingt ihr die Täuschung häufig genug, hat sie den Turing-Test bestanden.

Aber kann die Maschine deshalb denken wie ein Mensch? Versteht sie, was sie sagt und warum andere auf sie hereinfallen?

Nein, sagt der Philosoph John Searle. Besonders in seiner vereinfachten Form prüfe der Turing-Test lediglich eine sehr spezifische Funktionalität der maschinellen Intelligenz, nicht ihr Denkvermögen als Ganzes. "The Chinese Room" heißt der viel zitierte Essay, in dem Searle gegen Turing argumentiert: das chinesische Zimmer – ebenfalls ein Gedankenmodell.

Dabei sitzt eine Person in einem abgekapselten Raum. Lediglich ein kleiner Schlitz führt in die Welt außerhalb, durch ihn werden kleine, mit chinesischen Schriftzeichen bemalte Zettelchen in den Raum geschoben. Sie erzählen Geschichten, darunter stehen inhaltliche Rückfragen. Der Mann kann mit den Zettelchen jedoch nichts anfangen, hat die Schriftzeichen noch nie zuvor gesehen.

In seinem Raum liegt ein in seiner Muttersprache verfasstes Handbuch. Über die Bedeutung der Schriftzeichen steht auch darin kein Wort, dafür konkrete Hintergrundinformationen zu den Geschichten sowie Anweisungen, mit denen der Mann per Schriftzeichen antworten könnte. Mechanisch folgt er diesen Anweisungen, malt ihm unbekannte Zeichen, schiebt die Antwortzettel durch den Schlitz.

Auf der anderen Seite steht nun ein Mensch, der die Schriftzeichen versteht. Er weiß weder, wer in dem Raum sitzt, noch von dem Handbuch. Allein auf Basis der Antworten, argumentiert Searle, müsste er schlussfolgern, dass im "chinesischen Zimmer" ein Mensch sitzt, der wie er die Bedeutung der Schriftzeichen versteht. Der den Inhalt der Geschichten begriffen hat.

Große Sprachmodelle bestehen den Turing-Test ohne Probleme

Was Searle damit sagen möchte: Selbst wenn eine Maschine eine Tätigkeit erfolgreich absolviert, beherrscht sie noch lange nicht die zugehörige Fähigkeit. Die Maschine trägt Wissen in sich – das Handbuch –, sie selbst weiß aber nichts. Selbst wenn sie kommuniziert wie ein Mensch, den Turing-Test besteht und den Anschein macht, sie habe verstanden, kann sie nicht denken. Sie verarbeitet Symbole, mehr nicht.

Searles Essay erschien 1980. Dennoch erinnert er verblüffend stark an gegenwärtige Debatten rund um die großen Sprachmodelle (Large Language Models, LLM), die hinter Chatbots wie ChatGPT, Grok oder Perplexity agieren. Diese Sprachmodelle bestehen aus Neuronalen Netzwerken, die mit gigantischen Textmengen trainiert wurden, die menschliche Sprache zu verarbeiten und zu verstehen. Sie verwandeln die Texte in eine für sie lesbare Form, in Token. Das Sprachmodell erstellt ein Muster der Beziehungen zwischen den einzelnen Token, errechnet daraus Wahrscheinlichkeiten, mit denen es seine Antworten generiert. (Wie dies im Detail abläuft, lesen Sie hier.)

Den Turing-Test bestehen mittlerweile einige dieser Sprachmodelle. Zuletzt überzeugten GPT-4.5 von OpenAI und das von MetaAI entwickelte LLaMa für eine Studie der University of California San Diego Dutzende Probandinnen und Probanden von ihrer Menschlichkeit. Trotzdem glaubt die überwiegende Mehrheit der Fachwelt: Die Sprachmodelle verstehen kein Wort von ihrem Gebrabbel. Wie der Mann im chinesischen Zimmer folgen sie mechanisch übergeordneten Anweisungen, befolgen Wahrscheinlichkeiten.

Dass diese Maschinen dabei eine Komplexität erreichen, die für menschliche Hirne nicht mehr nachzuvollziehen ist, bedeutet nicht, dass sie selbständig denken. Im Gegenteil: Sie bestehen den Turing-Test, weil sie seine sehr spezifischen Anforderungen erfüllen, weil sie zwischenmenschliche Kommunikation imitieren und ausgezeichnet vorgaukeln, ein Mensch zu sein.

Dennoch diskutierten Fachleute schon lange vor dem Aufkommen der Chatbots die Möglichkeit einer Artificial General Intelligence: einer Allgemeinen Künstlichen Intelligenz. Eine solche Intelligenz wäre tatsächlich zu quasi-menschlichem Denken in der Lage. Sie könnte sich auf neue Situationen einstellen, verfügte über umfangreiches Wissen über die Welt und würde verstehen, was sie sagt.

Die Welt nach dem Turing-Test: Woher wissen wir, wie schlau Künstliche Intelligenz wirklich ist?

Die Voraussetzungen für eine solche Form der künstlichen Intelligenz berühren nicht nur technische, sondern auch philosophische Fragen. John Searle etwa, der Vater des chinesischen Zimmers, argumentiert, Computersysteme müssten erst ein Bewusstsein entwickeln. Dann könnten sie sich der Bedeutung der Symbole bewusst werden, mit denen sie hantieren. Andere Philosophen argumentieren, Maschinen bräuchten einen Zugang zur Welt, um den Symbolen Bedeutung zuordnen zu können. Sie bräuchten einen Körper, der Sinneseindrücke sammelt, der untrennbar mit seiner Umwelt verbunden ist. Aus diesem "In-der-Welt-Sein", wie es der Philosoph Martin Heidegger formulierte, bezieht der Mensch einen Großteil seines Wissens über die Welt. Eine Künstliche Intelligenz müsste demnach ebenso über eine Körperlichkeit verfügen, um zur Allgemeinen Künstlichen Intelligenz aufzusteigen.

Doch: Wüssten wir überhaupt, wenn es plötzlich so weit ist? Gibt es Verfahren, die Künstliche Intelligenzen nicht wie der Turing-Test auf eine bestimmte Fähigkeit testen, sondern auf ihre, nun ja, allgemeine Intelligenz?

Nein. Die Forschungsgemeinde scheitert schon an einer gültigen Definition von Allgemeiner Künstlicher Intelligenz. Vor einiger Zeit schlug ein Team Googles Deep Mind deshalb "Stufen der Intelligenz" vor: Auf Stufe 1 bringen Künstliche Intelligenzen demnach die gleichen kognitiven Fähigkeiten mit wie ein durchschnittlicher Erwachsener. Sie können auf ähnlich viel Situationen angemessen spontan reagieren und haben ein Verständnis von der Welt.

Braucht Künstliche Intelligenz einen Körper?

Darauf aufbauend entwickelte ebenfalls ein Google-Team 204 Aufgaben, die eine Künstliche Intelligenz abarbeiten solle. Sie stammen aus Bereichen der "der Linguistik, der kindlichen Entwicklung, der Mathematik, dem gesunden Menschenverstand, der Biologie, der Physik, der sozialen Voreingenommenheit, der Softwareentwicklung und vielem mehr", schreibt das Team in einem 2022 erschienenen Paper.

Der Neurowissenschaftler Gary Marcus hingegen argumentiert, Allgemeine Künstliche Intelligenz könne nur im Verbund mit einem Roboter auf den Prüfstand gestellt werden. Gelingt es ihm, Möbel aufzubauen? Die Sinneseindrücke zu verarbeiten, die Anleitungen zu verstehen und die richtigen Schlüsse zu ziehen?

Auch diese Tests seien kaum besser als der Turing-Test, sagen Kritiker. Selbst wenn ein humanoider Roboter durch die Küche wirbelt, Spülmaschinen ausräumt und Schlagsahne schlägt, könne man nicht sicher sein, dass dieser auch versteht, was er da tut: Dass er tatsächlich denkt und nicht mechanischen Regeln folgt, die kein Mensch mehr versteht.