Sachte, als wolle sie nach einem Strohhalm greifen, führt Tracy Dyson ihren rechten Zeigefinger zum Daumen. Der robotische Greifarm, der 400 Kilometer von ihr entfernt über dem Boden baumelt, braucht einen Moment, um zu reagieren. Dann ahmt er Dysons Handbewegungen nach. Beinahe geräuschlos streckt er seine Gelenke, fährt eine Ellenlänge nach vorn, packt zu.

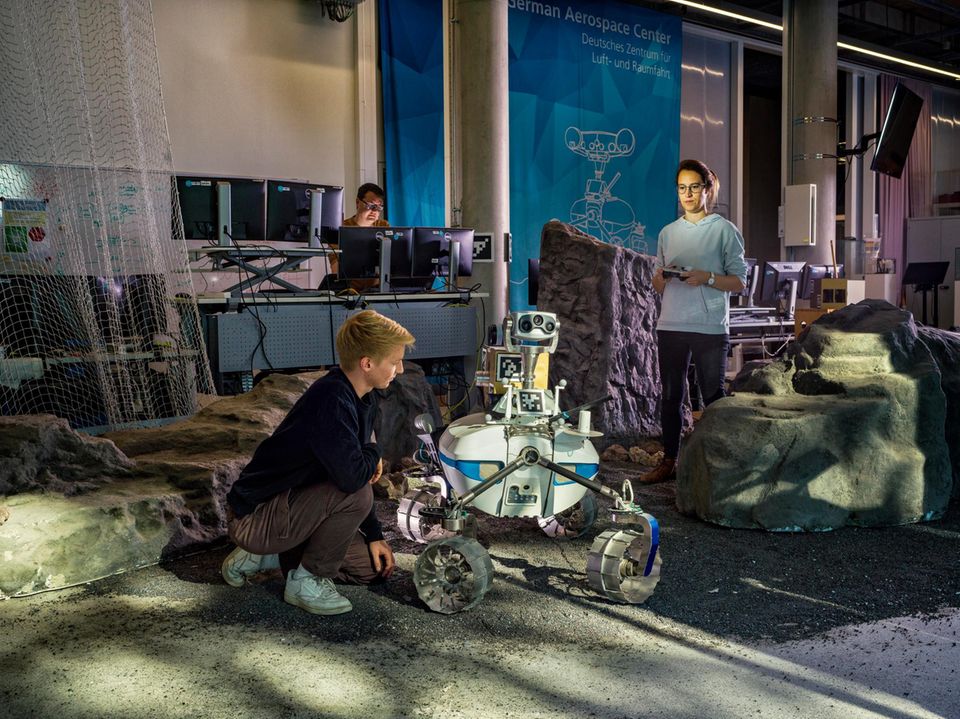

Dyson schwebt auf der Internationalen Raumstation (ISS). Damit sie in der Schwerelosigkeit nicht den Halt verliert, klemmen ihre Füße unter einer Metallstange. Ihr rechter Zeigefinger steckt in der schwarzen Stoffschlaufe eines ansonsten schneeweißen Controllers. Mit ihr steuert sie den robotischen Greifarm durch einen Hangar des Deutschen Zentrums für Luft- und Raumfahrt (DLR) im bayerischen Oberpfaffenhofen. Der Arm ist auf einem klobigen Gefährt verschraubt, hält nun einen faustgroßen Schaumstoffball umschlossen und rollt auf eine silberne Schale zu. Je näher der Rover der Schale kommt, desto behutsamer werden Dysons Bewegungen.

Eine Schrittlänge vor der Schale stoppt die Astronautin den Rover, zieht ihren Zeigefinger aus der Schlaufe. Mithilfe des Laptops vor ihr befiehlt sie der Maschine nun per Mausklick, den Ball in das Gefäß zu legen.

Doch statt einen Bogen um den Rand der Schale zu machen und seinen Greifer über ihr zu öffnen, drückt der Roboterarm seitlich dagegen. Wie in Zeitlupe schiebt er die Schale, die mit sechs dünnen Metallstangen auf dem Boden steht, in Schieflage.

Dann, just als die Schale zu kippen droht, hält der Roboter plötzlich inne. Auch das Getuschel der etwa zwei Dutzend Wissenschaftlerinnen und Wissenschaftler, die am Rand des Testfeldes hinter Monitoren stehen, verstummt. Verunsichert blicken sie zu einem Mann in ihrer Mitte: Seine Augen starren zornig ins Nichts, sein linker Daumen drückt auf einen roten Knopf.

Er hat den Roboter abgeschaltet.

Im Ernstfall hielte der Greifarm keinen Schaumstoffball, sondern einen Gesteinsbrocken. Auch hätte der Roboter keine Schale umgeworfen, sondern womöglich ein Loch in die Außenhaut einer Forschungsstation gerissen. Er stünde nicht auf dem mit Kunststoff überzogenen Boden eines Hangars in Bayern. Sondern auf dem Mond.

Die Rückkehr dorthin, so die offiziellen Pläne der amerikanischen Weltraumbehörde NASA, soll noch in diesem Jahrzehnt erfolgen. Für September 2025 ist eine erste bemannte Umrundung des Erdtrabanten geplant, frühestens ein Jahr später sollen wieder Menschen auf seiner Oberfläche landen. Dieses Mal jedoch wollen sie mehr hinterlassen als nur ein paar Fußabdrücke im Staub. Sie wollen Treibstoff und Sauerstoff aus den tiefen, mit Wassereis gefüllten Kratern am Südpol des Mondes gewinnen, wollen nützliche Elemente aus seinem Gestein extrahieren und wissenschaftliche Experimente durchführen.

Vor allem aber sollen sie testen, ob und wie es funktionieren könnte: ein Leben jenseits der Erde.

Noch sind Roboter oft unpräzise und tollpatschig

Ohne Roboter wird das nicht zu schaffen sein. Weil der Mond keine Atmosphäre hat, liegt die kosmische Strahlenbelastung dort etwa 800-mal höher als auf der Erde, die Temperaturen am Mondäquator schwanken zwischen plus 121 und minus 133 Grad Celsius. Um dort auszuharren, brauchen Menschen eine schützende Forschungsstation. Die sollen ferngesteuerte und autonome Maschinen errichten, eine robotische Vorhut.

Doch die Sache hat einen Haken. Roboter, die in der Lage sind, ein schlüsselfertiges Eigenheim im All zu bauen, gibt es noch nicht. Die meisten der gegenwärtigen Exemplare sind zu unpräzise und tollpatschig. Sie schätzen Entfernungen falsch, lassen Dinge fallen oder reißen zu heftig daran. Außerdem schaffen sie es kaum, sich in einer fremden Umgebung zurechtzufinden – fatal auf einer Mondbaustelle.

Kaum eine Forschungsdisziplin aber ist derzeit so sehr in Bewegung wie die Robotik, vor allem dank ihrer Verschmelzung mit künstlicher Intelligenz. Roboter lernen Handgriffe mittlerweile selbstständig, sie erahnen unbekannte Objekte, sind klug wie nie zuvor.

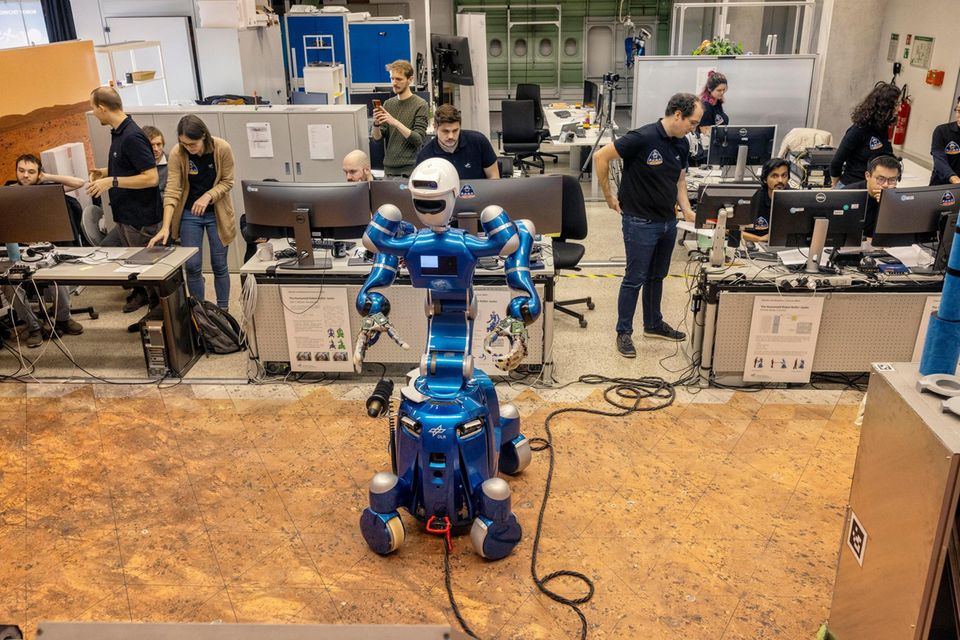

Das gilt auch für die drei Exemplare, die Tracy Dyson durch den Hangar in Oberpfaffenhofen manövriert. Mit "Bert", einem Vierbeiner im Dackelformat, sucht sie Schrauben zwischen hüfthohen Mondfelsen aus Plastik. "Interact", jener Rover, dessen Greifarm gerade noch rechtzeitig gestoppt wurde, bringt Schaumstoffbälle zu einer imaginären Mondbasis. "Justin", ein knapp zwei Meter hoher Humanoid, klaubt diese Schaumstoffbälle aus der Schale und bringt sie in eine Schachtel in der Ecke des Testfelds. Für die Steuerung von Justin stehen Dyson nur wenige Kommandos auf ihrem Laptop zu Verfügung. Der Hüne soll weitestgehend autonom agieren: die Königsdisziplin der Robotik.

Ein Humaoid wird erwachsen: Justin lernt eigenständiges Handeln

Als Daniel Leidner Justin zum ersten Mal traf, ähnelten dessen motorische Fähigkeiten noch denen eines Fünfjährigen. Der Roboter hatte gelernt, ein mit Gläsern beladenes Tablett waagerecht in den Händen zu balancieren, er fing vier von fünf Tennisbällen, die man ihm zuwarf, und er tanzte ausdrucksstark, wenn auch hüftsteif.

Wie die meisten Roboter seiner Generation folgte Justin dabei den strikten Vorgaben seiner Programmierer. Eine Befehlskette legte fest, wann er welche Gelenke strecken, mit welchen Fingern er wie zupacken sollte. Je komplexer die Aufgabe, desto länger der Computercode. Jedes Mal, wenn Justin einen Fehler machte, ergänzten seine Programmierer einige Zeilen.

"Irgendwann bestanden 80 Prozent des Codes aus Korrekturen", erzählt Daniel Leidner. Justin in diesem Zustand Aufgaben zu übertragen, die er selbstständig erledigt, war kaum denkbar.

Dann stellte Leidner das Denken des Humanoiden auf den Kopf.

Anfang der 2010er-Jahre schrieb der Informatiker den Computercode nicht länger nur aus der Perspektive des Roboters. Stattdessen verknüpfte er die ihn umgebenden Objekte mit passenden Befehlen. Erkannte Justin einen Stab, konnte er mehrere Aktionen ausführen: aufheben, werfen, in eine Öffnung schieben, fallen lassen. Der Roboter musste nicht länger Befehlsketten abspulen, um Aktionen aneinanderzureihen. Er kramte vielmehr das passende Muster für einzelne Bewegungen aus dem Gedächtnis hervor und fügte sie zusammen. Justin hatte gelernt, modular zu handeln: der Situation entsprechend. Ein Durchbruch.

Bald schon steuerten ihn die ersten Astronauten per Tablet aus dem All. Justin putzte eigenständig Solarpaneele, tauschte defekte Batterien aus, fegte Scherben. Mittlerweile gelingt es ihm in einer modifizierten Version sogar, sich neue Bewegungen selbst beizubringen: per "Deep Reinforcement Learning", mit künstlicher Intelligenz. Dafür erschaffen die Forschenden digitale Zwillingshände des Roboters. Sie simulieren die Kräfte, die Justins Finger auf ein Objekt ausüben, und versuchen, durch Ausprobieren die beste Lösung zu finden.

So hat Justin gelernt, einen Würfel in nach unten gerichteten Fingern zu drehen. Bis zu 4000 dieser digitalen Hände gleichzeitig sind in einer Simulation aktiv, über Stunden hinweg. Anfangs bewegen sich die Finger zufällig und lassen die Würfel ständig fallen. Jedes Mal, wenn das geschieht, erhält Justins digitaler Zwilling Strafpunkte und vermeidet fortan solche Bewegungen. Gelingt es ihm, den Würfel zu drehen, gibt es Pluspunkte. Über Millionen von Wiederholungen findet Justin so die passende Bewegung.

Künstliche Intelligenz revolutioniert die Robotik

Nun geht es darum, das Gelernte anzuwenden. "Keine Simulation ist perfekt", sagt Leidner. "Es gibt immer eine Kluft zwischen ihr und der Realität." Justin schließt sie im Erdgeschoss des DLR-Instituts für Robotik und Mechatronik. Er steht in der Mitte eines verwinkelten Raumes, umgeben von Artgenossen. "Toro", "Claudia" und "David", die weiteren humanoiden Roboter des DLR, verharren in ihren Ecken, während Justin die Bewegungen aus der Simulation wiederholt.

Zögerlich dreht er einen Holzwürfel um die eigene Achse. Er scheitert, der Würfel fällt klackernd auf einen Tisch. Sofort reicht ein Student Justin erneut einen Würfel. Dessen Position schätzt der Roboter über Kraftsensoren und die Stellung seiner Finger. Sobald er spürt, dass der Würfel zu fallen droht, schiebt er einen Finger stützend darunter – ein Trick, den ihm keiner der Forschenden im Vorfeld gezeigt hat. Binnen wenigen Minuten dreht Justin sechs Würfel in seiner rechten Hand und stapelt sie aufeinander. TUMDLR ist auf ihnen nun zu lesen: Technische Universität München, Deutsches Luft- und Raumfahrtzentrum.

Dass Maschinen derart geschickt und klug agieren, hielten viele Forschende bis vor Kurzem noch für eine Vision aus ferner Zukunft. Nun jedoch scheint es, als katapultiere künstliche Intelligenz die Robotik in neue Sphären. Auch die Roboter der privaten Entwickler holen auf. Teslas Humanoid "Optimus" faltet scheinbar gebügelte Hemden und setzt rohe Eier in einen Kocher. Sein Kollege "Figure 01" trägt mühelos Karosserieteile durch ein BMW-Werk in Spartanburg, South Carolina. Und der chinesische "Astribot S1" zieht in einem Werbevideo eine Tischdecke vom Tisch, ohne die Weingläser darauf umzuwerfen. Der "ChatGPT-Moment" der Robotik, sagen manche, stehe kurz bevor. Das Ergebnis wäre ein marktreifer Roboter, der selbstständig Geschirr spült, Wäsche wäscht und Besorgungen macht. Der Menschen aus brennenden Häusern rettet und auf hoher See nach Schiffbrüchigen sucht. Oder eben eine Forschungsstation im All errichtet.

Leidner lächelt: "Die Leute sehen solche Videos und denken: Super, übermorgen habe ich einen Humanoiden in meiner Wohnung. Aber so einfach ist das nicht."

Seit er die Forschungsgruppe für Justins Autonomie leitet, verbringt der 37-Jährige kaum noch Zeit mit dem Roboter selbst. Statt im chaotischen Erdgeschoss an Justins Code zu tüfteln, sitzt er meist im zweiten Stock seines Instituts. Hinter Leidners Schreibtisch hängen, in exakt bemessenen Abständen, das halbe Dutzend Preise, das er für seine Forschung eingeheimst hat. Daneben, auf Regalbretter gereiht, stehen Souvenirs von Dienstreisen: die japanische Super-Mario-Ausgabe für Nintendo, eine Festplatte, die einst am Teilchenbeschleuniger CERN verwendet wurde, eine chinesische Winkekatze. Leidner hat sie auf den Bauch gelegt: Ihr leises Klicken macht ihn kirre.

Die Werbevideos der Konzerne, sagt Leidner, zeigten weder die Missgeschicke der Roboter noch die vielen Entwicklerinnen und Entwickler, die zur Not den Aus-Knopf drücken. Sofern die Bewegungen überhaupt vom Roboter selbst ausgeführt werden: Internetnutzer entdeckten in Videos von Teslas Optimus die verkabelte Hand eines Menschen, die ein Hemd faltete: Offenbar wurde der Humanoid ferngesteuert. Hinzu kommt, dass viele der per KI gelernten Fähigkeiten nicht einfach auf andere Situationen übertragbar sind. "Wenn ein Roboter gelernt hat, Würfel zu stapeln, kann er das erst einmal nur mit diesen spezifischen Würfeln", sagt Leidner. "Sobald er das Gelernte unter anderen Bedingungen anwenden soll, bekommt er Schwierigkeiten."

Lehrbücher bezeichnen das Problem als Moravec’sches Paradox. Für einen Computer sei es vergleichsweise einfach, schrieb der Robotiker Hans Moravec bereits in den 1980er-Jahren, einen Intelligenztest zu bestehen oder Dame zu spielen. Einer Maschine hingegen die Wahrnehmung und Mobilität eines Einjährigen zu vermitteln, sei fast unmöglich. Das gilt bis heute.

Mittlerweise gelingt es dem Humanoiden Justin, sich Bewegungen selbst beizubringen

Während Roboter für spezifische Aufgaben programmiert werden, ist der Mensch untrennbar mit seiner Umwelt verbunden. Jenes "In-der-Welt-Sein", wie es der Philosoph Martin Heidegger formulierte, ist fester Bestandteil des menschlichen Daseins. Der Großteil unseres Wissens über die Welt stammt aus lebenslangen Interaktionen mit ihr: Dass ein Apfel zu Boden fällt, wissen Menschen, seit sie ihn fallen ließen, lange bevor Isaac Newton die Gesetze der Schwerkraft beschrieb. Ein Mensch, der isoliert von äußeren Einflüssen aufwüchse, wäre aufgeschmissen, sobald er die Erde betritt.

Gleiches gilt für Homo sapiens als Gattungswesen. Der genetische Code, der unsere Körper formt und unser Verhalten beeinflusst, ist das Erbe eines Prozesses der Anpassung an unsere Umwelt: der Evolution.

Robotern fehlt all das. Weder verfügen sie über die Sinne, mit denen Menschen ihre Umwelt wahrnehmen. Noch haben sie ein intuitives Verständnis für die physikalischen Eigenschaften dieser Welt. Trotzdem brauchen die Maschinen eine vage Vorstellung ihrer Umwelt und müssen wissen, wie sie auf diese wirken, wenn sie ihre Körper bewegen. Manche Entwicklerteams zeigen ihren Robotern deshalb die Welt im Schnelldurchlauf. Sie füttern die Maschinen mit echten Fotos und Videos, zeigen ihnen tausendfach, wie Menschen etwa eine Spülmaschine öffnen oder Schranktüren schließen.

Aus dem Datenwust leiten die Maschinen Bewegungsmuster ab. Je komplexer die Bewegung, desto mehr Daten sind vonnöten. KI-Unternehmen wie Googles DeepMind haben bereits Plattformen gegründet, auf denen die Bewegungsdaten der Roboter hinterlegt sind. Das Ziel, so verspricht es das Unternehmen, sei eine Art Roboter-Internet: eine Bibliothek voll mit nützlichem Wissen über die Welt.

Auf dem Mond muss der Roboter nicht so fingerfertig sein wie ein Haushaltsroboter

Daniel Leidner geht einen anderen Weg. Sollte Justin eines Tages auf dem Mond arbeiten, muss er weniger fingerfertig sein als ein Haushaltsroboter. Allerdings soll er, weit entfernt von menschlicher Hilfe, selbstständiger sein als seine Artgenossen auf der Erde. Deshalb simuliert sein digitaler Zwilling in Echtzeit, wie sich Justins Umwelt verändern würde, wenn jede seiner Bewegungen funktioniert wie geplant. Diese Simulation vergleicht der Roboter dann mit den Informationen seiner Sensoren. Im Gegensatz zu herkömmlichen Robotern verarbeitet er dabei nicht nur bloße Koordinaten, sondern "semantische Zustände", wie Leidner sie nennt: sinnhafte Beschreibungen der Welt.

Als die Astronautin Dyson den Roboter steuert, soll Justin Probenbehälter sortieren: fausthohe Plastikröhrchen, wie sie in Chemielaboren verwendet werden. Als Justin sich dem Tisch nähert, auf dem Halterungen für die Röhrchen verschraubt sind, ploppt auf Dysons Laptop ein neues Fenster auf. Justin schlägt vor, das schwarze Röhrchen in Halterung zwei zu stellen. "Dann mal los", nuschelt die Astronautin und klickt auf das Befehlsfeld. Doch plötzlich weigert sich der Roboter. Irritiert beugt sich Dyson näher an den Bildschirm, liest, was Justin ihr mitteilt: Halterung zwei ist bereits von einem grauen Röhrchen belegt. Nun schlägt Justin ihr alternative Handlungen vor: Er könne erst das graue Röhrchen herausnehmen und dann das schwarze einsetzen. "Soll ich das tun?", fragt Dyson auf der ISS. "Unbedingt", antwortet ein Forscher unten auf der Erde in sein Mikrofon. Er lächelt. Justin hat auf seine Umgebung eigenständig reagiert: Das mache "ein paar Wissenschaftler hier unten gerade sehr, sehr glücklich".

Der Ansatz, einen digitalen Zwilling in Echtzeit zu nutzen, ist neu. Erst im Frühjahr 2024 erhielt Leidner eine Förderung für die kommenden fünf Jahre. Die Forschungsgruppe für "Fehlertolerante Autonomiearchitekturen" soll Robotern beibringen, ihre Missgeschicke zu erkennen und, wenn möglich, zu beheben. Auf dem Mond, wo jedes mitgebrachte Instrument ein Vermögen kostet, sind das unverzichtbare Fähigkeiten. Dass etwa Justins einarmiger Kollege Interact auch dort eine Entfernung falsch einschätzen und eine Auffangschale umwerfen könnte, ist durchaus möglich. Dann jedoch wird kein Mensch im Notfall einen roten Knopf drücken. "Der Roboter müsste selbstständig innehalten und Alarm schlagen", sagt Leidner. "Dafür braucht er ein Verständnis für die Situation. Der Roboter muss wissen, dass er gerade gegen eine Schale drückt und sie zu kippen droht."

Mittelfristig will das Team auch Chatbots in das System integrieren. Astronautinnen und Astronauten könnten dann mit dem Roboter sprechen wie mit einem Kollegen. Sie könnten erfragen, warum etwas schiefgegangen ist, was der Roboter genau in den vergangenen fünf Minuten versucht hat. Denn sobald Roboter an ihre Grenzen stoßen, muss ein feinfühligeres Wesen übernehmen und sie händisch steuern.

Obwohl Tracy Dyson zu den erfahrensten Astronautinnen der Welt gehört – 2007 flog die Amerikanerin zum ersten Mal ins Weltall, damals noch in einem Space Shuttle –, fällt es ihr schwer, die Roboter durch das Testfeld in Oberpfaffenhofen zu manövrieren. Es dauert quälend lange, bis der Greifer reagiert. Entsprechend behäbig greift der Arm des Interact-Rovers nach "Mondgestein", den grau eingefärbten Schaumstoffbällen.

Die Steuerung der Roboter muss so intuitiv wie möglich sein

Die Forschenden auf der Erde lassen Dyson machen. Gelassen beobachten sie den Livestream der ISS auf ihren Bildschirmen: Auch im Ernstfall wäre die Astronautin weitestgehend auf sich allein gestellt. Nur eine Raumfahrttechnikerin mit lila gefärbten Haarspitzen trippelt nervös auf der Stelle. Als der ferngesteuerte Arm gegen die Schale boxt und ihr Chef den Notfallknopf drückt, schließt Rute Luz entsetzt die Augen.

Seit Monaten tüftelt die Portugiesin an einer neuen Steuerung für die drei Roboter. Wo in früheren Versuchen vor allem Zahlen auf dem Laptop der Astronauten blinkten – die Koordinaten der Roboter, ihre Temperatur, die Akkulaufzeit –, flackern heute Videobilder. Dyson kann wählen, ob sie aus der Sicht eines Roboters oder aus der Vogelperspektive auf das Geschehen blickt. Darunter zeigt eine animierte Karte die Position von Bert, Justin und Interact. Wer beschäftigt ist, dessen Figürchen ist ausgegraut. Die anderen Roboter kann Dyson anklicken und zwischen Aktionen wählen. Greife den Stein. Gehe zurück zur Raumfähre. Schau dich um.

Dass all das wirkt wie ein Computerspiel, ist kein Zufall. "Eine Astronautin hat während ihrer Ausbildung keine Zeit, ausgiebig mit Robotern zu trainieren", sagt Luz. Die Steuerung müsse deshalb intuitiv sein, binnen wenigen Minuten erlernbar. Die 30-Jährige will Brücken bauen zwischen Mensch und Maschine: "Wer einen Roboter bauen möchte, der auf den Mond fliegt, darf nicht bei der Technik stehen bleiben. Der muss die Psyche des Menschen verstehen."

Luz ist Doktorandin beim Human Robotics Interaction Lab der europäischen Raumfahrtbehörde (ESA), einer voll gerümpelten Werkhalle hinter den Dünen der niederländischen Nordseeküste. An der Wand hängen die Forschungsobjekte ihrer Vorgänger: wuchtige Exoskelette, in denen der Arm der Raumfahrenden komplett verschwand, von der Schulter bis zum Handballen.

Daneben baumelt, beinahe zierlich und von einem Dickicht aus Kabeln umschlungen, eine Sigma.7: der schneeweiße Controller, der auch auf der ISS schwebt. Der Controller ist an drei frei beweglichen Streben befestigt und in alle Richtungen schwenkbar. Seine Sensoren registrieren Bewegungen der menschlichen Finger und leiten sie als elektrisches Signal an den robotischen Arm weiter. Mehr noch: Stößt ein Roboterarm auf ein Hindernis, übermitteln seine Sensoren ein Signal an den Controller. Die Astronautin Tracy Dyson spürt, wenn Interact einen Stein greift. Als reichten ihre Arme zur Erde.

Die neue Raumstation soll als Zwischenstopp für Raumfahrende dienen

Bis das Signal aber über das NASA-Weltraumzentrum in Texas und verschiedene Satelliten auf der ISS ankommt, vergehen etwa 400 Millisekunden. Ebenso lange dauert es, bis der Roboter die Signale von der Raumstation empfängt. Solche Verzögerungen seien für geübte Astronautinnen und Astronauten noch verschmerzbar, sagt Alin Albu-Schäffer, Direktor des DLR-Instituts für Robotik und Mechatronik. "Brauchen die Signale eine Sekunde oder länger, wird es schwierig. Bei Verzögerungen über zwei Sekunden fühlt sich jede Bewegung an, als rühre man in einem Topf voll Honig."

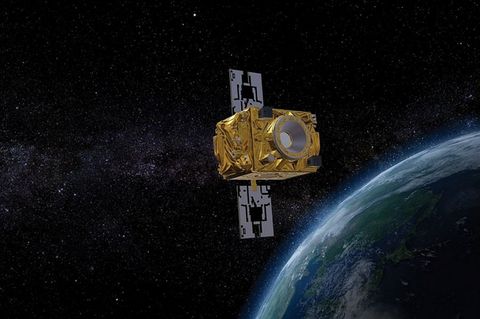

Bis Videosignale eines Roboters die durchschnittlich 384.400 Kilometer zwischen Erde und Mond zurückgelegt haben, vergehen ca. 1,3 Sekunden. Gerade noch kurz genug, so haben es sowjetische Ingenieure bereits 1970 mit ihrem ferngesteuerten Rover "Lunochod 1" bewiesen, um die Oberfläche des Mondes zu erkunden. Von der Erde aus filigrane Handgriffe auszuführen wäre hingegen unmöglich. Große Hoffnungen ruhen deshalb auf dem Lunar Gateway.

Die neue Raumstation soll größtenteils noch in diesem Jahrzehnt in die Umlaufbahn des Mondes gebracht werden und Funkkontakt zur Erde halten. Sie soll als Zwischenstopp für Raumfahrende dienen, die auf dem Mond landen. Und als Kommandozentrum für die Maschinen auf dessen Oberfläche. Die Übertragungszeit wäre auf ein Minimum reduziert. Erste Versuche für ein solches Szenario mit haptischer Steuerung gab es bereits vor einer knappen Dekade. Etwa zwei Dutzend Astronautinnen und Astronauten, darunter der Deutsche Alexander Gerst, haben die Roboter seither von der ISS aus auf der Erde gesteuert: durch Testfelder der ESA und des DLR und, aus einem Hotelzimmer am Fuße des Ätna, auch über dessen staubige Vulkanhügel. Spätestens bei den Artemis-Missionen V und VI, wenn also die ersten Astronauten vom Lunar Gateway zur Mondoberfläche pendeln, sollen auch zwei Roboter aus Deutschland dabei sein: "Sie könnten zum Beispiel eine erste Plattform bauen, auf der die Mondfähre landet", sagt Institutsleiter Albu-Schäffer.

Wie diese Roboter aussehen werden, ist ungewiss. Justin wurde nicht gebaut, um ins All zu fliegen. Der Koloss wiegt insgesamt rund 200 Kilogramm, die Schlitze zwischen seinen Gelenken wären binnen Minuten voller Mondstaub. Er ist zunächst eine Forschungsplattform, auf der Leidner und sein Team robotische Intelligenz erschaffen. Das maschinelle Gehirn, das sie entwickeln, wird eines Tages in einen anderen, raumfahrttauglichen Körper gesetzt.

Welche Körper das sein könnten, wird am RETHI erforscht: dem von der NASA finanzierten Institut für resiliente extraterrestrische Habitate. Noch stehe man am Anfang, sagt Justin Werfel, Harvard-Wissenschaftler und Leiter der Robotiksparte des RETHI. Niemand weiß, wie eine zukünftige Mondstation aussehen wird und welche konkreten Bauteile die Roboter aufbauen und warten sollen.

Die Mondstation müsste an die Maschinen angepasst sein, als robotergerechtes Eigenheim

Vorschläge gibt es zuhauf, etwa das Konzept des "PneumoPlanet" aus den Forschungslaboren der ESA: Bis zu 16 ultraleichte Kuppeln würden demzufolge als kleine Pakete ins All transportiert und erst auf der Mondoberfläche zur ihrer eigentlichen Größe aufgeblasen. Die Kuppeln würden, um sie gegen Strahlung und extreme Temperaturen zu schützen, von einer mehrere Meter dicken Schicht pulverisierten Mondgesteins bedeckt. Ein anderer Vorschlag will die unterirdischen Lavaröhren nutzen, die vermutlich ein verzweigtes Netz unter der Mondoberfläche bilden. Sie stammen aus der vulkanischen Frühgeschichte des Erdtrabanten, als große Lavaströme über sein Gelände zogen. Als die äußere Schicht solcher Ströme erstarrte, bildeten sich offenbar Dutzende Meter breite Tunnel, die über Jahrmillionen hinweg von Mondgestein und Staub bedeckt wurden: natürliche Schutzbunker.

In großen Simulationen testen Werfel und sein Team, welche Rolle Roboter einnehmen könnten, wenn etwa einer der vielen Mini-Meteoriten, die beständig auf den Mond einprasseln, ein Loch in die Außenwände der Station reißt. Um effizient zu agieren, sagt Werfel, dürften die Sinne des Roboters nicht bei seinen Gliedmaßen enden, die Maschine müsse in das Habitat verwoben sein. Beispielsweise wären alle Temperatursensoren in der Mondstation mit den Robotern verbunden, ebenso Druck- und Sauerstoffmesser, die Alarm schlagen, falls irgendwo Luft entweicht. Mehr noch: Das Habitat selbst müsse an die Maschinen angepasst sein, als robotergerechtes Eigenheim.

Wasserfilter etwa, die in der Raumfahrt schon seit Jahren Standard sind, können bislang nur unter Anwendung vielfältiger Handgriffe gewechselt werden. Werfels Team konstruierte nun neue Filter mit nur einem Hebel, die Roboter deutlich leichter selbst wechseln könnten. Auch Stufen seien für Menschen kein Problem, für Roboter auf Rädern jedoch ein unüberwindbares Hindernis.

Bislang, sagt Werfel, verbringen Astronautinnen und Astronauten auf der ISS im Schnitt 15 Stunden pro Woche damit, zu putzen. Wären die Flächen und Instrumente in der neuen Raumstation für sie zugänglich, könnten Roboter diese Arbeit übernehmen. Ohnehin wäre die Raumstation wohl nicht dauerhaft von Menschen besetzt. Die Roboter wären zeitweise auf sich allein gestellt.

Warum, möchte man fragen, sollten dann überhaupt Menschen auf dem Mond landen? Wenn die Forschenden ihre Ziele tatsächlich erreichen, wären die intelligenten Roboter kaum noch auf die unmittelbare Hilfe von Astronauten angewiesen. Wäre es da nicht einfacher, die Maschinen allein ins All zu schicken?

Daniel Leidner zögert, bevor er antwortet. Dann huscht ein Lächeln über seine Lippen. "Können Sie sich vorstellen, dass Justin irgendwo auf dem Mond sitzt und einfach nur den Blick schweifen lässt?", fragt er. "Dass er plötzlich und aus eigenem Antrieb diesen einen Stein aufhebt, der im Sonnenlicht glitzerte? Nein? Ich auch nicht." Um nicht nur statistische Anomalien, sondern wirklich Neues zu entdecken, brauche es urmenschliche Gefühle. Neugier etwa. Mut. Und die Sehnsucht nach der Fremde.

Der Tag, an dem Justin endgültig abgeschaltet wird, rückt unaufhaltsam näher

Des Menschen Rückkehr zum Mond wird Justin nicht mehr erleben. Vor einigen Monaten feierte Leidner mit seinen Kolleginnen und Kollegen den 18. Geburtstag des Humanoiden. Für Roboterverhältnisse ist er damit ein Greis. "Für uns ist Justin perfekt", sagt Leidner, der sein Berufsleben mit dem Roboter verbracht hat. "Wir kennen seinen Körper genau, wissen um seine Macken. Nun konzentrieren wir uns darauf, sein Denken weiterzuentwickeln."

Und dennoch: Für viele von Justins Gliedmaßen gibt es kaum noch Ersatzteile, neue werden nicht mehr produziert. Als am Tag vor dem Versuch mit der Astronautin Tracy Dyson einer seiner Finger brach, verbrachte ein Doktorand die halbe Nacht damit, ihn zu flicken. Der Tag, an dem Justin endgültig abgeschaltet wird, rückt unaufhaltsam näher. Wenn er gekommen ist, will Leidner den Humanoiden Hand in Hand ins Deutsche Museum führen.

Gut möglich, gesteht er, dass dann Tränen fließen. Justin hingegen wird keine Miene verziehen.