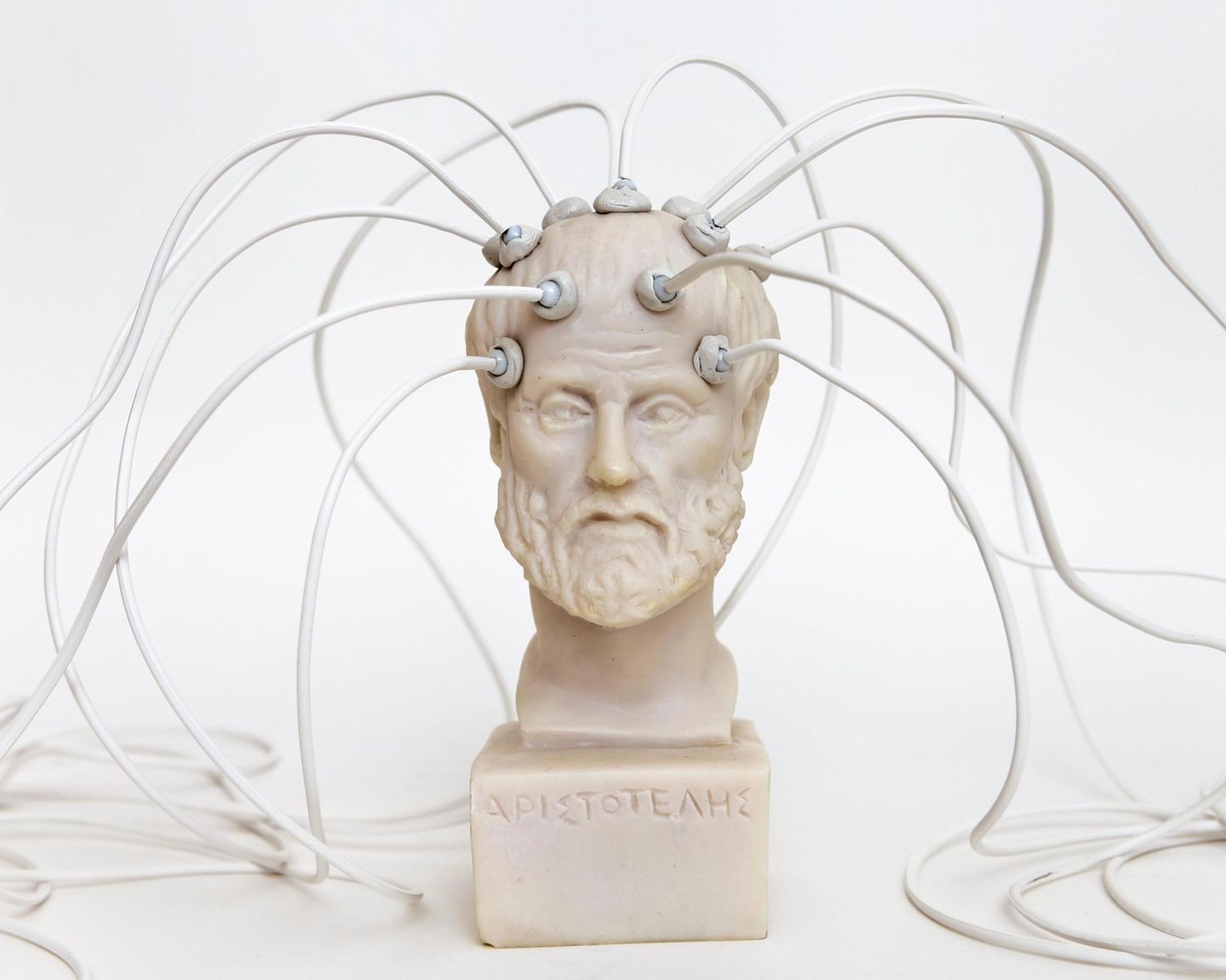

Cyborgs und Menschen mit eingepflanzten Computerchips im Kopf sind längst nicht mehr Charaktere aus Science-Fiction-Romanen. Immer wieder verfeinern Ingenieurinnen die Implantate ihrer Patienten:innen. Mittlerweile statten sie die Mini-Maschinen mit künstlichen Intelligenzen aus, die die Idee vom Gedankenlesen greifbar machen. Mit einem Sprachmodell ist es der Elektroingenieurin Erin Kunz von der Stanford University und ihrem Team gelungen, innere Monologe von ihren Proband:innen in Echtzeit zu übersetzen – und der Gedankenleser kommt mit Passwortschutz.

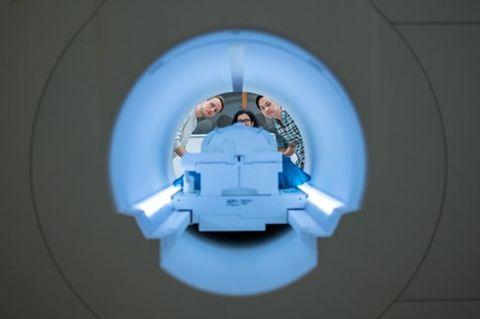

Kunz führte die Studie mit Menschen durch, die aufgrund von ALS oder Schlaganfällen schwere Sprachstörungen haben und Neuroprothesen für ihre Einschränkung benötigen.

Sie und ihr Team implantierten allen Teilnehmenden Mikroelektroden-Arrays im jener Region des Kortex, in der das motorische Sprachzentrum verortet ist. Wenn wir einen inneren Monolog führen, dann aktiviert das Hirn dieselben neuronalen Schaltkreise, die auch beim lauten Sprechen aktiv sind. Sie sind arbeiten allerdings auf niedrigerem Niveau, als würde der Kopf das reden nur üben. Diese Aktivität ist unter anderem durch Amplituden-Schwellenwerte messbar.

"Ich brauche gute Musik", übersetzte die KI fehlerfrei

Ein RNN-System (rekurrentes neuronales Netz) analysiert diese Messwerte und liefert alle 80 Millisekunden eine Einschätzung, welche Sprachlaute, die betreffende Person wahrscheinlich gedacht hat. Die Personen müssen dafür die Muskeln nicht benutzen, die sie ansonsten für die Lautbildung aktivieren würden, was für Patient:innen mit Lähmungen erleichternd sein kann. Das RNN orientiert sich an 39 Grundlauten und kann auch eine Pause erkennen – von flüssige Sprache kann man hier noch nicht sprechen.

Dafür kommt das Sprachmodell ins Spiel: Es kennt 125.000 Worte und kann aus den dekodierten Lauten Sätze rekonstruieren. Ältere Sprach-Neuroprothesen, die ohne künstliche Intelligenz funktionieren, mussten Buchstabe für Buchstabe entschlüsseln.

Das neue Modell testeten die Forschenden allerdings nur bei zwei der vier Versuchspersonen. Je nach Testdurchlauf übersetzte der Gedankenleser zwischen 50 und 74 Prozent aller Wörter richtig. Die Sätze wurden in Echtzeit auf einem Bildschirm angezeigt und zusätzlich hörbar umgewandelt.

Aus "Jene Person drängt dich" wurde "Während rot du"

Um die mentale Privatsphäre der Teilnehmenden zu wahren, gaben Kunz und ihr Team den Menschen einen Code aus Worten: „Chitty Chitty Bang Bang“. Wenn sie diese Abfolge dachten, aktivierte sich die KI und lauschte den Gedanken. Der Code funktionierte wie ein mentaler An-und-Aus-Schalter, mit sehr hoher Genauigkeit und in nahezu 100 Prozent der Fälle. Auch weil das Passwort absichtlich phonetisch komplex ist und wohl kaum im inneren Monolog auftaucht.

Die Forscher stellten fest, dass Teile der inneren freien Sprache auch dann entschlüsselt werden konnten, wenn die Teilnehmer nicht explizit angewiesen wurden, innere Sprache zu verwenden – deshalb funktionierte die KI auch beim Zählen oder bei der chronologischen Organisation von Gedanken. Dies deutet darauf hin, dass das System auch Gedanken dekodieren könnte, die Benutzer nicht bewusst äußern möchten.

Trotzdem schreiben die Autor:innen der Studie, dass es nicht möglich gewesen sei vollständige, verständliche Sätze während des freien Denkens genau zu entschlüsseln. Unser Gedankenfluss, gerade bei autobiografischen Themen, ähnelt zu sehr Kauderwelsch, um ihn übersetzen zu können.

Um auch andere Arten von Sprachbehinderungen mit Neuroprothesen ansprechen zu können, wollen die Forschenden sich weitere Hirnregionen ansehen und die Genauigkeit des Systems verbessern, sagt Kunz.