Schnell die Bewerbung von ChatGPT schreiben lassen oder den Bot als Therapie-Ersatz befragen: KI-Technologien ziehen bei vielen Menschen in immer mehr Lebensbereiche ein – und fressen dabei schier unvorstellbare Mengen an Energie, zumal sie immer leistungsfähiger werden.

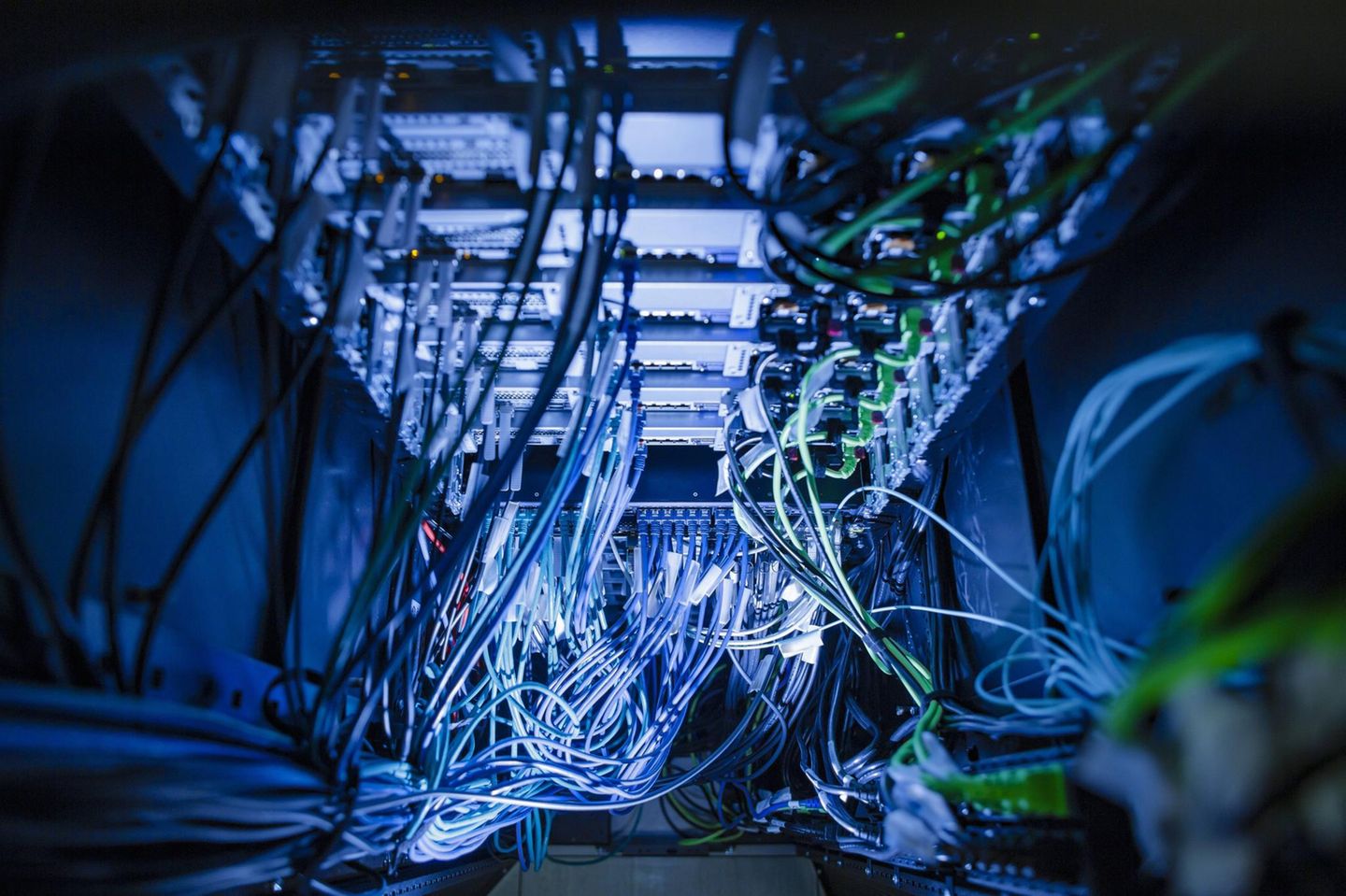

Der Direktor der Internationalen Energie-Agentur (IEA), Fatih Birol, hält Künstliche Intelligenz für "eine der größten Geschichten" des heutigen Energiesektors – die bislang aber völlig unterschätzt werde. "Der weltweite Strombedarf von Rechenzentren wird sich in den nächsten fünf Jahren mehr als verdoppeln und bis 2030 so viel Strom verbrauchen wie ganz Japan heute", erklärte Birol kürzlich. "Rechenzentren in den Vereinigten Staaten werden voraussichtlich fast die Hälfte des Anstiegs der Stromnachfrage ausmachen, in Japan mehr als die Hälfte."

Die Universität Cambridge geht in einer Berechnung davon aus, dass sich der Energiebedarf der Big-Tech-Branche in den nächsten 15 Jahren durch KI mindestens verfünffachen werden. Die Vorstellung, dass Länder wie Großbritannien führend im Bereich der KI werden und gleichzeitig ihre Klimaziele erreichen könnten, sei "magisches Denken auf höchster Ebene", heißt es im Vorwort des Berichts.

Tech-Konzerne und der wachsende Energiehunger

Mit wachsender Leistungsfähigkeit der Sprachmodelle steigt der Energiebedarf. "Und deshalb überlegt jedes große IT-Unternehmen, wie man jetzt damit umgeht", erklärt der KI-Experte Michael Färber von der Technischen Universität Dresden. Der Konzern Meta, der hinter Facebook, Instagram und WhatsApp steht, habe einen Energievertrag über 20 Jahre abgeschlossen, Google setze auf kleinere Atomkraftwerke. "Die überlegen sich auf jeden Fall, wie sie kostengünstig wegkommen können."

Tatsächlich räumte Google in seinem Nachhaltigkeitsbericht ein, dass die Treibhausgas-Emissionen für 2023 um 13 Prozent gestiegen seien und gegenüber 2019 sogar um 48 Prozent – was den Spagat aufzeigt, den es bedeutet, im KI-Bereich voranzukommen und gleichzeitig klimafreundlicher werden zu wollen. Auch bei Microsoft stiegen die Emissionen im Vergleich zum Jahr 2020 um mehr als 23 Prozent an, wie aus dem jüngsten Nachhaltigkeitsbericht hervorgeht.

Unterschiede zwischen Modellen und Themen

Wie groß der Energieverbrauch einzelner Modelle ist, lässt sich teils schwierig feststellen. Gerade das Training der KI-Anwendungen gilt als enormer Energiefresser. Ein Team um Maximilian Dauner von der Hochschule München zeigte kürzlich im Fachjournal "Frontiers in Communication", dass der Energieverbrauch nicht nur zwischen verschiedenen Sprachmodellen sehr variiert, sondern auch je nach Thema. "Manche eurer KI-Prompts könnten 50 Mal mehr CO2-Emissionen verursachen als andere", fasst das Team seinen Befund zusammen.

Die Gruppe fand einen Zusammenhang zwischen der Größe des Modells, dem sogenannten "Reasoning" – also gewissermaßen dem Rechenaufwand –, der Generierung von Tokens – also Wörtern oder Phrasen – und den verursachten Emissionen.

Sie konzentrierte sich auf Modelle wie DeepSeek, Cogito oder Qwen, die auf lokalen Servern ausgeführt werden, da so eine direkte Messung des Energieverbrauchs möglich war. "Gängige Sprachmodelle wie ChatGPT und ähnliche laufen auf Servern von OpenAI oder anderen Unternehmen. Daher besteht keine Möglichkeit, den Verbrauch direkt zu messen", erklärt Dauner.

Philosophie klimaschädlicher als Geschichte

Anfragen, die längere Reasoning-Prozesse benötigten, etwa zu Philiosophie oder abstrakter Algebra, hatten der Studie zufolge sechsmal höhere Emissionen als etwa Standard-Schulwissen in Geschichte.

Zudem hatten jene Modelle eine schlechte Klimabilanz, die besonders akkurat antworteten. "Derzeit sehen wir bei den Sprachmodellen einen klaren Kompromiss zwischen Genauigkeit und Nachhaltigkeit", hält Dauner fest.

Dass sich der Energieaufwand je nach Thema oder Fragestellung unterscheidet, ist für den Experten Färber nicht sonderlich überraschend. "Faktisches Wissen - etwa: was ist die Hauptstadt von Japan oder wann war die französische Revolution - ist leicht abrufbar und das Wissen ist online, etwa bei Wikipedia, beschrieben", erklärt er. Mehr gerechnet werden müsse bei Fragen, bei denen die KI zunächst Aspekte verbinden müsse.

Während Modelle immer leistungsfähiger und energiehungriger werden, werden gleichzeitig KI-Funktionen fast überall integriert.

Man will eigentlich nur ein einzelnes Pfannkuchenrezept

Als Nutzerin hat man nicht die Wahl, beim Googlen etwa nach einem Pfannkuchenrezept zu verhindern, dass man eine KI-Zusammenfassung aus drei verschiedenen Rezepten ausgespielt bekommt. Aljoscha Burchardt, der sich am Deutschen Forschungszentrum für Künstliche Intelligenz (DFKI) unter anderem mit Nachhaltigkeit beschäftigt, kritisiert das: "Ich als Verbraucher werde hier einfach vor vollendete Tatsachen gestellt und habe nicht die Wahl."

Spricht man länger mit Burchardt über dieses Thema, kann man zuhören, wie er im Gespräch Ideen für mehr Transparenz entwickelt: ein Schalter, mit dem man beim Googlen die KI-Funktion ausschalten kann. Oder ein Desktop-Feature als Transparenz-Ampel, die anzeigt, wie viel Energie meine heutigen KI-Anfragen gefressen haben.

Dass Alltagsanwendungen und auch das schnelle Googlen mittlerweile KI-Funktionen beinhalten, hält auch Färber für einen oft übersehenen Aspekt. Wird das den Energieverbrauch immens steigern? "Ja, auf jeden Fall", meint er.

Killt oder rettet KI das Klima?

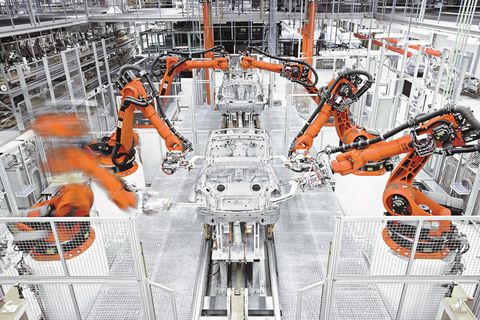

Macht KI es also schwerer, Klimaziele zu erreichen? Schwierig zu berechnen, vor allem da KI-Technologien teils auch für mehr Energieeffizienz sorgen können. "Wenn du einen Menschen hast, der 25 Jahre Kindheit und Ausbildung genossen hat, im Einfamilienhaus wohnt, den Hund mit Fleisch füttert und Avocados isst und ins Büro fährt, um Dokumente abzutippen, dann ist das eine beschissene Energiebilanz fürs Dokumente abtippen. Da kannst du wahrscheinlich das KI-System trainieren und hast eine bessere Bilanz", sagt Burchardt. Studien weisen auf das Potenzial von KI hin, wenn es um effizientere Bewässerung oder die Steuerung von Energieanlagen geht – also durch KI möglich werdende Einsparpotenziale.

"KI fällt ja nicht in den luftleeren Raum, sondern verändert Prozesse, Prozeduren, Abläufe und Dinge, die da sind und die möglicherweise ineffizient sind, unnötig sind", hält Burchardt fest. Entscheidend sei, ob es Rebound-Effekte gebe – also bestimmte KI-Aufträge hinzukämen, also: Lasse ich mein Profilbild von KI im Stil des japanischen Zeichentrickfilmstudios Ghibli erstellen, was früher einfach nicht möglich war? Einen ähnlichen Effekt gibt es Burchardt zufolge bei E-Scootern, die kaum eine Autofahrt, sondern eher Fußwege oder Radfahrten ersetzen.

Nicolas Alder vom KI-Lehrstuhl am Hasso-Plattner-Institut betont, dass "es vorrangig vom Energiemix abhängig sein wird, wie und ob sich KI auf die Klimaziele auswirken wird". Er hält fest: "Für Europa heißt das, dass wir sowohl günstige als auch saubere Energie bereitstellen müssen. Günstig, damit wir als Standort überhaupt attraktiv für Data Center und deren gigantischen Energiebedarf sind. Sauber, da sonst Klimaziele unter Druck geraten können."

Schon ohne KI haben Länder große Probleme, ihre Klimaziele einzuhalten und auf erneuerbare Energiequellen umzustellen. Der rapide wachsende Energiebedarf verschärft also ein ohnehin schon gravierendes Problem.

Es fehlt Transparenz – und damit ein Bauchgefühl

Aus Sicht von Burchardt haben wir in der digitalen Welt kein gutes Bauchgefühl mehr dafür, wie viel Energie unser Handeln eigentlich verbraucht. "Während wir in der analogen Welt ein gutes Sensorium dafür haben oder wissen, was wir tun, wenn wir hin- und herfahren, uns eine Badewanne einlassen und Avocados oder Würstchen essen, so haben wir in der digitalen Welt keine so guten Sensoren. Und im KI-Bereich dann noch weniger oder haben zum Teil auch gar nicht die Wahl", sagt Burchardt.

Bislang fehlten die Kompetenzen, als Nutzerin oder Nutzer sich bewusst je nach Anfrage für ein energieeffizienteres Modell zu entscheiden. Das liege auch daran, dass Transparenz fehle – etwa wie viel Ressourcen eine Anfrage verbrauche. "Es ist nicht leicht, in dieser Hinsicht ein guter Mensch zu sein."

Studienautor Dauner und Kollegen hoffen trotzdem, dass ihre Forschung die Sensibilität schärft: "Nutzer können ihre Emissionen erheblich verringern, wenn sie die KI auffordern, prägnante Antworten zu generieren oder den Einsatz von Modellen mit hoher Kapazität auf Aufgaben zu beschränken, die diese Leistung wirklich erfordern."

Ist KI hier wirklich nötig?

Burchardt bezeichnet die Balance von KI-Vorteilen und Energieverbrauch als "Gestaltungsaufgabe". Einiges müsse auf politischer Ebene reguliert werden – wie etwa die Transparenz. Jeder Einzelne könne sich aber auch fragen: "Ist KI hier wirklich nötig?"

Arbeiten die Tech-Konzerne eigentlich an dem Problem? Experten bewerten die bisherigen Entwicklungen in dieser Hinsicht unterschiedlich: Aus Sicht von Färber ist das Bestreben, KI-Anwendungen energieeffizienter zu gestalten, durchaus Teil des aktuellen Wettbewerbs. "Es ist eine relevante Komponente geworden und war es eigentlich zum Teil schon immer", meint er. Einige Unternehmen würden kleinere Modelle entwickeln, die lokal auf dem Smartphone laufen können, sowohl aus Energie- als auch aus praktischen Gründen.

Eine mögliche Nische für Europa

Alder vom Hasso-Plattner-Institut sieht in der Trainingsphase von KI-Modellen noch keine Bestrebungen, Energie einzusparen. Bei der Nutzung hingegen habe der Energieverbrauch sehr relevante Auswirkungen für OpenAI und andere Anbieter, "und wir können davon ausgehen, dass diese intern an der Optimierung arbeiten, da dies ein großer Kostenfaktor ist".

Burchardt hingegen beobachtet eher einen Wettbewerb Richtung Höher, Schneller, Weiter als einen Fokus auf die Energiebilanz. "Das wird bei dem Power Game derzeit nicht gemacht. Da redet man eher über Atomkraftwerke und vielleicht auch Solarzellen oder Öl und Gas in den Emiraten, die die großen Systeme powern können." In vielen Bereichen, etwa in der medizinischen Forschung oder in der Industrie, sei es jedoch ohnehin praktikabler, auf energiesparende Modelle zu setzen. Denn oft heißt das auch, man benötigt weniger Daten und in speziellen Anwendungen sind ohnehin Hybrid-Lösungen besser, die generative KI beispielsweise mit Datenbanken verbinden.

Für Europa, das zwischen den US-Techkonzernen und chinesischen Riesen wie DeepSeek bislang noch seine Rolle in der KI-Welt sucht, sieht Burchardt hier Potenzial.

Es braucht mehr Transparenz

Gina Neff von der Universität Cambridge hält fest: "Generative KI kann bei der Entwicklung von Klimalösungen hilfreich sein, aber es besteht ein reales Risiko, dass die Emissionen aus dem KI-Ausbau die Gewinne fürs Klima übersteigen, wenn Technologieunternehmen ihre Netto-Null-Ziele aufgeben und riesige KI-getriebene Gewinne anstreben." Die Forscher aus Cambridge fordern mehr Transparenz – es brauche globale Standards, um die ökologischen Kosten von KI besser erkennen und regulieren zu können.