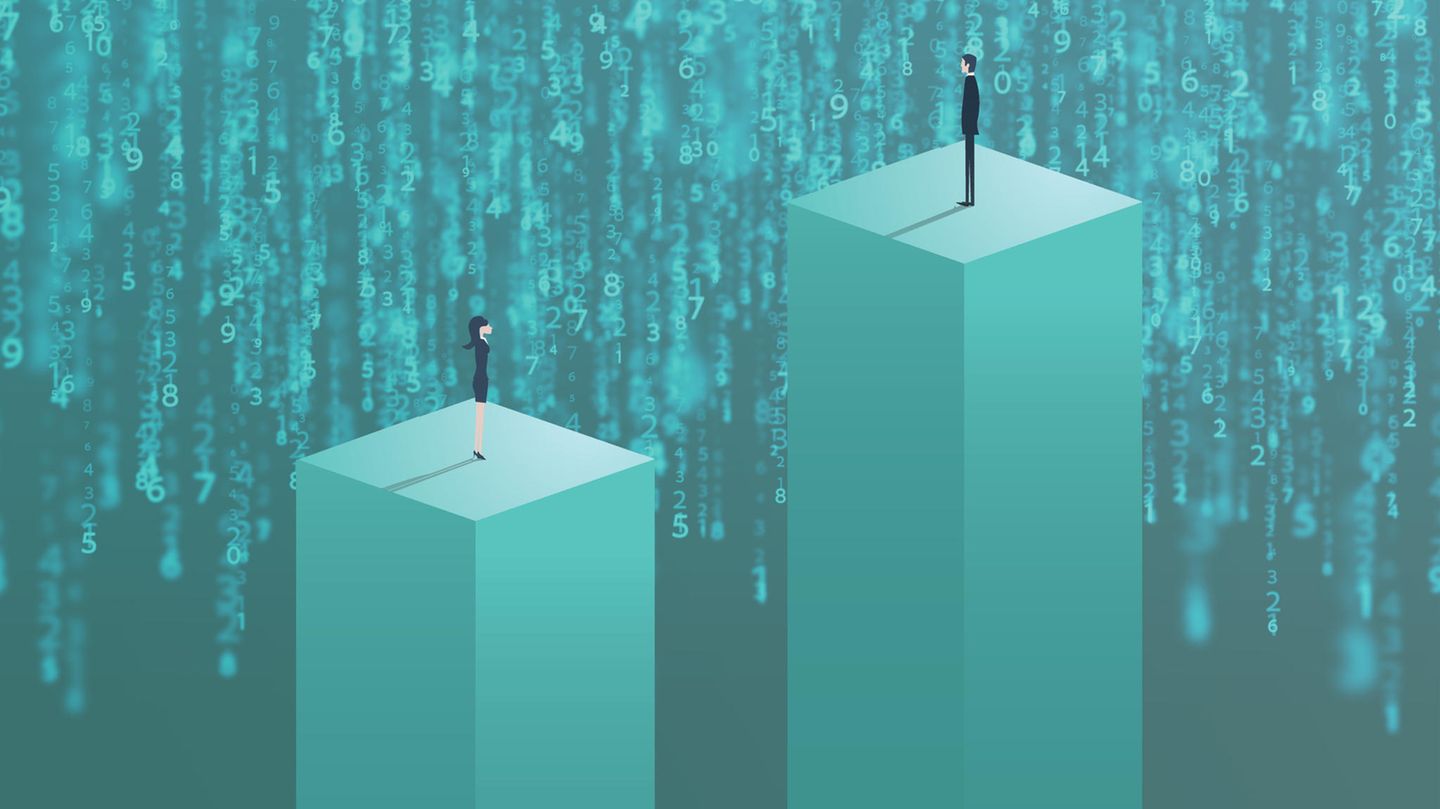

KI-gesteuerte Programme können komplexe Berechnungen erstellen, Kunst kreieren und mittlerweile sogar populäre Songs produzieren. Doch trotz allen technischen Fortschritts, sind die "Wundermaschinen" in mindestens einem Punkt noch nicht in der Zukunft angekommen: Geschlechtergerechtigkeit.

Beauftragt man das KI-Visualisierungsprogramm Midjourney beispielsweise damit, Bilder eines Menschen zu generieren, sind auf allen der vier erstellten Bilder Männer abgebildet. Fragt man nach klassisch männlich-konnotierten Berufen (beispielsweise geschlechtsneutral mit "Scientists" nach Wissenschaftler*innen) sind die Ergebnisse – wenig überraschend – ähnlich einseitig. Doch auch bei Berufen, die mittlerweile hauptsächlich von Frauen ausgeübt werden (wie Lehrer*innen) überwiegen männliche Visualisierungen.

Frauen sind das "andere Geschlecht", wie es Simone de Beauvoir 1949 bereits benannte. Und das scheint sich auch in einer Zeit, in der künstliche Intelligenz innerhalb weniger Minuten ein 944-Seiten-Buch schreiben könnte, nicht geändert zu haben.

Datenlage führt zu schlechterer Versorgung von Frauen

Dass unsere Gesellschaft für Männer geschaffen ist, merken Menschen, die mit weiblichem Geschlecht geboren sind, alltäglich: das Produkt im obersten Supermarkt-Regal ist unerreichbar, im Büro ist es immer eigentlich etwas zu kühl und auch auf der kleinsten Einstellung sitzt der neue "Unisex"-Reiserucksacks zu locker.

Doch die Auswirkungen des genderspezifischen Designs enden nicht bei diesen vermeintlich harmlosen Beispielen, wie es Caroline Criado-Perez mit ihrem Buch "Unsichtbare Frauen" weiterreichend bekannt machte. Denn dass es nicht nur die Reiserucksäcke sind, die notirisch falsch sitzen, sondern auch Sicherheitsgurte im Auto, führt dazu, dass Autounfälle für Frauen 17 Prozent häufiger tödlich enden. Beispiele, die wie dieses im wahrsten Sinne des Wortes lebensentscheidenden sind, gibt es in der Medizin zu Hauf.

Zurückführen lässt sich all das auf die zugrundeliegenden Daten, die nicht geschlechtersensitiv erhoben wurden. In einer Welt, die nicht gerecht funktioniert, verstärken massenhaft gesammelte Daten (sogenannte "Big Data") auch Vorurteile und Ungerechtigkeiten und bilden so eine weitere subtile Form von Diskriminierung. So entstand unter anderem der sogenannte "Gender Data Gap", der sich im Angesicht des Aufstrebens von Technologien, die darauf angewiesen sind, aus großen Datenmengen Muster und Trends zu erkennen, als besonders fatal erweist.

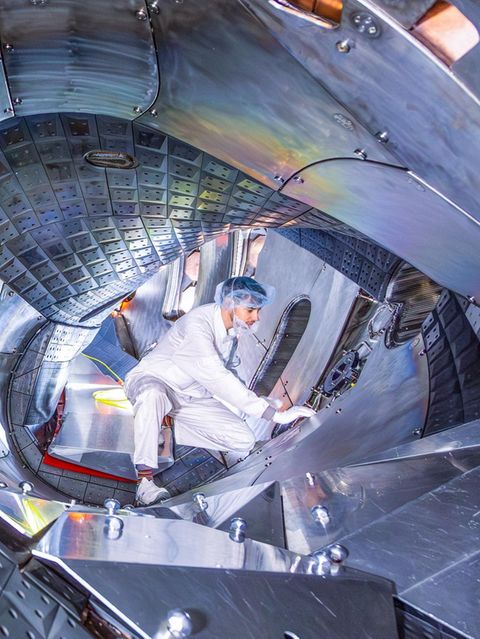

Denn mittlerweile werden auch in der Medizin KI-Modelle vermehrt eingesetzt, was zu schlechteren Behandlungen für Frauen führen kann. Beispielsweis sind entsprechende Modelle zur Brustkrebsdiagnose bei Frauen oft weniger genau, da sie auf männlichen Brustbildern trainiert wurden.

Big Data: Mehr Fairness gesucht

Doch die diskriminierenden Auswirkungen der Datenverzerrung zeigen sich auch am Arbeitsmarkt. Bereits jetzt nutzen viele Unternehmen KI-Systeme beispielsweise für Bewerbungsprozesse, um Profile zu analysieren und Kandidat*innen auszuwählen – der Versandriese Amazon begann damit schon 2014. Auch diese Systeme übernehmen oft Vorurteile aus jenen Daten, die ihre Trainingsgrundlage waren auf denen sie trainiert wurden. Wenn historische Daten zeigen, dass Männer in bestimmten Berufen erfolgreicher sind, können Frauen und nicht-binäre Personen benachteiligt werden. Auch in personalisierter Werbung, die auf Stereotypen basiert oder bei sprachgesteuerten Assistenten, die nur auf männliche Stimmen reagieren zeigen sich die Auswirkungen des Gender Data Gaps.

Und natürlich reproduziert künstliche Intelligenz, die auf Big Data basiert nebst sexistischer auch rassistische und klassistische Diskriminierung.

Dafür, wie man KI für den Weg in eine gerechtere Gesellschaft nutzen könnte, gibt es bereits verschiedene Ansätze. Zum einen soll das Bewusstsein für die diskriminierenden Datenverzerrung gestärkt werden und Unternehmen dazu angehalten werden, dieser entgegenzuwirken. Wissenschaftler*innen arbeiten bereits an intersektionalen Datensätzen, die alternativ eingesetzt werden können. Außerdem verlangen Expert*innen, dass die Transparenz der verwendeten Daten erhöht wird und die Entwickler*innen mehr zu Verantwortung gezogen werden. Auch Aufklärungsarbeit (an Schulen etc.) kann helfen, größeres Bewusstsein in der Gesamtbevölkerung zu schaffen.

Neben der lückenhaften Datensets, trägt auch die geringe Diversität in der Tech-Branche und insbesondere unter KI-Entwickler*innen zur weiteren Reproduktion patriarchaler und rassistischer Machtstrukturen bei. Studien bestätigen: Die Menschen, die die Digitalisierung gestalten sind meist männlich, weiß und gut-verdienend. Oft werden so die Perspektiven von weniger privilegierten Menschen bei der Produktentwicklung außer Acht gelassen und Vorurteile können eher unbemerkt in Modelle einfließen, wenn die Betroffenen nicht an der Entwicklung beteiligt sind.

Auch von Seiten der Politik gibt es bereits Ansätze, entsprechende Richtlinien zu veranlassen. So wird beispielsweise in der 2021 verabschiedeten nationale Gleichstellungsstrategie 2030 des deutschen Bundestags erstmals das konkrete Ziel geschlechterspezifischen Datenerhebung in den Statistiken und Studien des Bundes formuliert.

Das "World Economic Forum" überprüft entsprechende Entwicklungen jedes Jahr im Rahmen eines Global Gender Gap Report und stellte letztes Jahr fest: Würden keine weiteren Maßnahmen eingeleitet werden, bräuchte es noch 132 Jahre, um die geschlechtsspezifische Datenlücke zu schließen.

Darüber, ob die Entwicklung von künstlicher Intelligenz die Welt gerechter machen kann oder Ungleichheit nur verschärfen wird, sind sich Wissenschaftler*innen uneinig. Doch der Ruf nach einer breiten öffentlichen Diskussion, in der ethische Grundsätze künstlicher Intelligenz neu verhandelt werden und herrschende Machtverhältnisse in Frage gestellt werden sollen, wird lauter und dringlicher.