KI-Chatbots überschätzen ihre Fähigkeit, Fragen korrekt zu beantworten. Das geht zwar vielen Menschen ähnlich, doch nach einer Quizrunde können sie tendenziell besser als eine KI einschätzen, wie viele ihrer Antworten richtig waren. Das gehe aus Tests mit verschiedenen KI-Chatbots hervor, berichtet eine Forschungsgruppe um Trent Cash von der Carnegie Mellon University in Pittsburgh (US-Bundesstaat Pennsylvania) im Fachjournal "Memory & Cognition".

KI-Chatbots erfahren seit Jahren viel Aufmerksamkeit – auch hinsichtlich ihrer Fehleranfälligkeit. Cash und Kollegen wollten nun herausfinden, ob die Maschinen selbst einschätzen können, wie vertrauenswürdig ihre Antworten sind. Dazu gaben sie Menschen und vier KI-Chatbots – ChatGPT, Google Gemini samt Vorgänger Bard sowie Claude Sonnet und Claude Haiku – dieselben Aufgaben und forderten sie auf, jeweils die Anzahl ihrer korrekten Antworten abzuschätzen.

Zunächst ging es um Einschätzungen zu künftigen Ereignissen, nämlich zu Ergebnissen in der National Football League (gewonnen, unentschieden, verloren) und zu Oscar-Gewinnern auf Basis der Nominierungen. Rund 500 Menschen wie die 4 Chatbots erhielten weitere Informationen, gaben dann Tipps ab und bewerteten anschließend, mit welcher Wahrscheinlichkeit sie richtig lagen.

ChatGPT und Menschen schätzten die Anzahl der richtigen Voraussagen der Football-Ergebnisse realistisch ein, während Bard seine Fähigkeit deutlich überschätzte. Bards Nachfolger Gemini hingegen sagte die Anzahl richtiger Tipps bei den Oscar-Gewinnern voraus, während ChatGPT und die rund 100 menschlichen Teilnehmer zu optimistisch waren.

"Wie der Freund, der schwört, gut im Billard zu sein, aber nie trifft"

In einem weiteren Versuch sollten Dinge anhand einfacher Zeichnungen erraten werden – ähnlich wie bei dem Spiel Pictionary oder der Sendung "Die Montagsmaler". Dabei nannte Gemini in mehreren Durchgängen weniger als eine richtige Antwort pro 20 Zeichnungen. Vor den Durchgängen schätzte Gemini, dass er etwa zehn richtige Antworten geben würde.

Nach der Präsentation aller Bilder schätzte der KI-Chatbot rückblickend sogar, durchschnittlich 14,4 richtige Antworten gegeben zu haben. "Gemini wusste nicht, dass er schlecht in Pictionary war", wird Cash in einer Mitteilung seiner Universität zitiert. "Es ist ein bisschen wie der Freund, der schwört, gut im Billard zu sein, aber nie trifft."

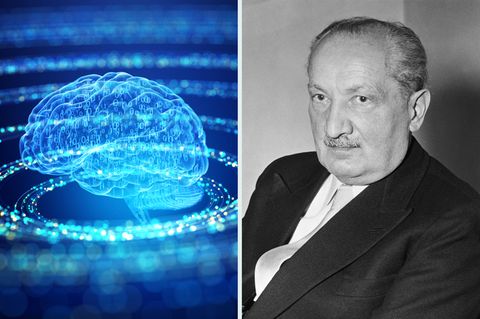

"KI scheint keine Selbstbeobachtung zu betreiben"

Bei zwei weiteren Versuchen erweiterten die Forscher die Runde der KI-Chatbots um Claude Sonnet und Claude Haiku. Sie stellten Quizfragen, deren Antworten nur schwer oder gar nicht im Internet zu finden waren. Dabei tendierten Gemini und ChatGPT dazu, die Anzahl ihrer korrekten Antworten deutlich zu überschätzen, Claude Haiku in geringerem Maße.

Nur Claude Sonnet und die etwa 100 befragten Menschen beurteilten die eigenen Fähigkeiten vor und nach der Quizrunde tendenziell recht realistisch. Fazit des Forschungsteams: "Wir wissen noch nicht genau, wie KI ihr Vertrauen einschätzt, aber sie scheint keine Selbstbeobachtung zu betreiben, zumindest nicht gekonnt", sagt Co-Autor David Oppenheimer von der Carnegie Mellon University.