Manches, das Menschen mithilfe einer künstlichen Intelligenz (KI) erschaffen, ist schlicht lustig. So posiert Papst Franziskus, der sich gerne als Fürsprecher der Armen und Mittellosen geriert, in einer strahlend weißen, aufgeplusterten Luxus-Daunenjacke. Auf der Brust seiner Heiligkeit prangt ein silbern glänzendes Kreuz und wenn er durch die getönten Gläser seiner Designerbrille direkt in die Kamera blickt, ähnelt der 86-Jährige eher einem Gangsterrapper im Ruhestand als dem Oberhaupt der römisch-katholischen Kirche.

Anderes, das Menschen mithilfe einer KI erstellen, ist potenziell gefährlich. Wenige Tage bevor Donald Trump sich tatsächlich vor einem Gericht in New York verantworten musste, gingen auf Twitter Bilder von seiner vermeintlichen Verhaftung viral: Der ehemalige US-Präsident wird von Polizeibeamten über den Asphalt geschleift; wutentbrannt will er sich losreißen. Es wird geschubst, getreten, geschlagen.

Wenig später, als der chinesische Staatschef Xi Jinping auf Besuch in Moskau war, zeigten Bilder seinen russischen Gastgeber Wladimir Putin in unterwürfiger Geste: Kniend küsst er Xi Jinping die Hände. Und in Deutschland postete Norbert Kleinwächter, stellvertretender AfD-Fraktionsvorsitzender im Bundestag, ein Bild von einem knappen Dutzend schreiender Männer. Sie tragen dunkle Bärte, wirken aggressiv – und ballen gewaltbereit die Fäuste. Darunter, in schwarz-weiß-roten Farben, brüllt Kleinwächter selbst: "Nein zu noch mehr Flüchtlingen!"

Zwar erkennt man bei genauem Hinsehen, dass keines dieser Bilder ein echtes Foto sein kann. Auf Twitter und in anderen sozialen Netzwerken wurden sie schnell als Fakes entlarvt und eher zur Belustigung als zur Empörung geteilt. Dennoch illustrieren sie eine bislang kaum seriös einzuschätzende Gefahr für den gesellschaftlichen Diskurs. Denn seit einige Unternehmen Bildgeneratoren frei zugänglich gemacht haben, die von einer KI gestützt werden, aber relativ leicht zu bedienen sind, wird das Netz mit fotorealistischen KI-Fakes geflutet. Wer etwa DALL-E oder Midjourney bedienen nutzen möchte, muss keine Programmiersprache beherrschen: Meist reicht eine einfache Prompt, also eine detaillierte umgangssprachliche Anweisung in Worten, um ein überzeugendes Ergebnis zu erzielen.

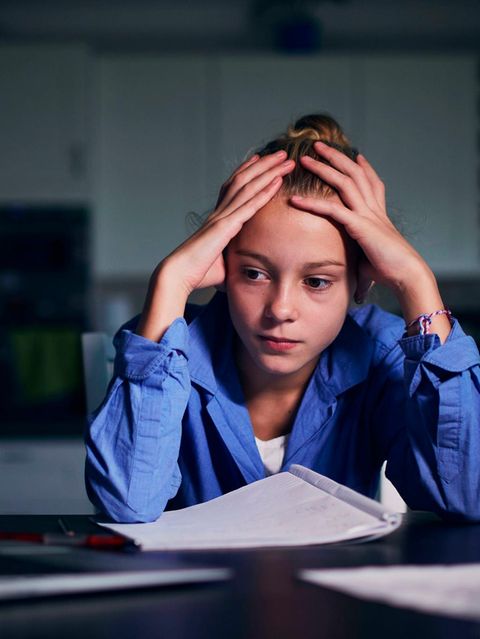

Höchste Zeit also, zu lernen wie man KI-Bilder von echten Fotografien unterscheiden kann. Diese fünf Tipps machen den Anfang:

1. Nutzen Sie Ihren "gesunden Menschenverstand"!

"Die Programme verstehen nicht, was sie erschaffen", sagt der Fotograf Boris Eldagsen, der seit Jahren fast ausschließlich mit generativer KI experimentiert. "Sie spucken Wahrscheinlichkeiten aus, die in Text- und Bildform gepresst werden." Manchen KI-Bildern sieht man das an: In ihrer Summe sehen sie fotorealistisch aus; Farben, Kontraste, Konturen erscheinen stimmig. Manche Details jedoch gehen gegen jede Vernunft.

Dann erscheint der Traktor, der im Abendlicht über die Felder fährt, merkwürdig "aufgesetzt", weil seine Reifen nicht im Boden versinken, sondern darüber schweben. Dann ist das Gesicht eines Protestierenden merkwürdig perfekt ausgeleuchtet, obwohl suggeriert wird, dass er inmitten einer Menschenmasse die Faust gen Himmel reckt und eine menschliche Fotografin sicher kein künstliches Licht hätte aufbauen können. Dann halten Polizisten, die im Hintergrund einer Demonstration zu sehen sind, plötzlich selbst Protestbanner in der Hand.

Hier zeigt sich eine der großen Herausforderungen jeder Anwendung künstlicher Intelligenz: Die selbstlernenden Programme können gigantische Datensätze verarbeiten und sich selbst Regeln geben, die für das menschliche Gehirn kaum noch nachvollziehbar sind. Eine menschliche Lebensrealität zu simulieren, aus der sich so etwas wie ein "gesunder Menschenverstand" speist, gilt manchen Wissenschaftler*innen als schier unmöglich.

2. Entlarven Sie typische KI-Fehler!

Bislang haben Bildgeneratoren wie DALL-E oder Midjourney große Probleme mit Körperproportionen. Oft wirken die Hände der gezeigten Personen merkwürdig deformiert: Die vorderen Fingerknochen sind teilweise doppelt so lang wie die mittleren oder so groß wie der Handteller. In manchen Bildern haben manche Personen sogar weniger oder mehr als fünf Finger. Papst Franziskus, der auf dem eingangs erwähnten KI-Bild in weißer Daunenjacke posiert, hat nur vier Finger an der linken Hand.

Auch Zähne, die von einer KI generiert wurden, wirken oft nicht wie menschliche Hauer, sondern wie aneinandergereihte, blitzweiße Legosteine. Auch bei Menschen, die eher im Bildhintergrund KI-generierter Bilder zu sehen sind, wirken Ohren, Augen und Mundwinkel manchmal merkwürdig deformiert.

Vergleicht man jedoch die Bilder, die heute generiert werden, mit solchen, die vor wenigen Monaten entstanden sind, ist klar: Diese bislang typischen Fehler werden nicht lange bleiben und damit nicht mehr lange als Erkennungszeichen für KI-Bilder herhalten können. Denn die Technik entwickelt sich im rasanten Tempo weiter.

3. Prüfen Sie die Nachrichtenlage!

Um so wichtiger ist es, Kriterien zu finden, die sich nicht auf die Machart des Bildes beziehen und andere Informationen miteinbeziehen. Wem ein täuschend echtes Bild in die Facebook- oder Twitter-Timeline gespült wird, das behauptet, einen großen Skandal wie etwa Trumps Verhaftung auf offener Straße zu zeigen, der sollte die Nachrichtenlage prüfen. Oft reicht dafür eine schnelle Google-Suche und der Blick auf große Nachrichtenportale: Wäre der ehemalige Präsident der USA öffentlichkeitswirksam verhaftet worden, hätten etliche Medienschaffende alles daran gesetzt, schnell zu berichten.

4. Nutzen Sie die Bilderrückwärtssuche!

Aber auch das gehört zu Wahrheit: So manches Mal verschlafen alle große Medienhäuser eine "Breaking News". In anderen Fällen dauert es einige Zeit bis zur ersten Berichterstattung, weil Fakten verifiziert werden müssen. Außerdem gibt es genug historische Beispiele, in denen nicht-etablierte Journalistinnen große Nachrichten berichteten, die ihnen lange niemand glauben wollte.

Wie also lässt sich prüfen, ob ein Bild echt ist, wenn kaum jemand darüber berichtet, es aber keine eindeutigen Hinweise auf einen Fake im Bild selbst gibt? Hinweise liefert die Bilderrückwärtssuche. Sie funktioniert ähnlich wie die Suche nach Schlagworten im Netz, zum Bespiel über Google, Bing oder das russischen Pendant Yandex: Einfach eine Bilddatei – oft reicht ein Screenshot – einfügen und schon werden diejenigen Homepages ausgespuckt, auf denen das Bild ins Netz gestellt wurde.

Ist ein Bild bereits viral gegangen, ist es schwer, seinen eigentlichen Ursprung zu finden. Mit wenigen Klicks erhält man jedoch einen guten Überblick darüber, wo das Bild sich derzeit verbreitet. Und ob es nicht schon als Fake entlarvt wurde.

Die Bilderrückwärtssuche gibt außerdem Aufschluss darüber, seit wann ein Bild im Netz kursiert. Das ist besonders hilfreich bei Bildern, die zwar echte Fotografien sind, aber Jahre alt und nun in verfälschende Kontexte gesetzt werden.

5. Nutzen Sie Kartentools, um die Umgebung zu prüfen!

Es kann außerdem helfen, sich einmal in der Umgebung umzusehen – digital natürlich, zum Beispiel per Google Street View: Gibt es die grüne Wiese im Hintergrund der Trump-Verhaftung wirklich? Sehen die Fenster der Regierungsgebäude wirklich aus wie die im Hintergrund der Bilder? Gleichen die Straßenschilder, die bei vermeintlichen Protesten in Indien gezeigt werden, überhaupt denen im Land?

Wenn all das nicht hilft, tut es vielleicht das Wetter. Mit einer kurzen Internetrecherche lässt sich herausfinden, ob es an einem bestimmten Tag in Washington wirklich dauerhaft geregnet hat. Oder ob das eine Einbildung der KI und des Menschen dahinter gewesen ist.